Google 最新发布的 Gemma 3 270M 模型将改变本地 AI 开发的格局。Gemma 3 270M 这个轻量级大语言模型(LLM)仅需 27 亿参数,却能在普通笔记本电脑上流畅运行,无需高端 GPU,甚至在 4GB 内存的设备上也能稳定工作。

那么本文将手把手教你如何在本地部署 Gemma 3 270M,包括环境配置、模型加载及实际应用示例,让你零成本体验前沿 AI 能力!

为什么选择 Gemma 3 270M?

在大模型动辄千亿参数的时代,Gemma 3 270M 的出现为开发者提供了全新选择。它的核心优势在于:

- 极致轻量化:模型文件仅 520MB,可直接下载到本地,无需依赖云端服务

- 低资源需求:支持 CPU 运行,4GB 内存即可启动,兼容大部分现代电脑(包括旧款笔记本)

- 性能均衡:虽然参数规模小,但在代码补全、文本生成和简单推理任务中表现出色,尤其适合开发原型验证

- 隐私安全:本地运行意味着数据无需上传至第三方服务器,适合处理敏感信息

- 开源免费:基于 Apache 2.0 许可证,个人和商业用途均无需付费,可自由修改和分发

本地运行 Gemma 3 270M 的准备工作

硬件要求(最低配置)

- 处理器:Intel Core i5(4 代及以上)或 AMD Ryzen 5

- 内存:4GB RAM(建议 8GB 以获得流畅体验)

- 存储:至少 1GB 空闲空间(用于模型文件和依赖库)

- 操作系统:Windows 10/11、macOS 12+或 Linux(Ubuntu 20.04+)

软件依赖需提前安装以下工具:

- Python 3.10+(推荐 3.11 版本,兼容性更佳)

- 包管理工具:pip(通常随 Python 自带)

- 虚拟环境(可选但推荐):venv 或 conda

分步部署指南

步骤 1:创建并激活虚拟环境

为避免依赖冲突,建议使用虚拟环境隔离项目:

# 创建虚拟环境

python -m venv gemma-env

# 激活环境(Windows)

gemma-env\Scripts\activate

# 激活环境(macOS/Linux)

source gemma-env/bin/activate 步骤 2:安装必要的 Python 库

需安装 Hugging Face 生态工具及模型运行依赖:

# 基础依赖

pip install transformers torch sentencepiece

# (可选)用于图形界面交互

pip install gradio transformers:加载 Gemma 模型的核心库torch:提供底层计算支持(CPU 模式足够运行)sentencepiece:处理模型的分词逻辑gradio:快速搭建交互界面(非必需,适合可视化操作)

步骤 3:获取 Gemma 3 270M 模型文件

Gemma 模型需通过 Google 官方渠道获取:

- 访问 Google Gemma 官网,点击“Get started”

- 同意使用条款,选择“Gemma 3 270M”模型

- 通过 Hugging Face Hub 下载(需关联 Google 账号),或直接获取模型权重文件

模型文件结构:

gemma-3-270m/

├── config.json # 模型配置

├── generation_config.json # 生成参数设置

├── model-00001-of-00002.safetensors # 模型权重(部分1)

├── model-00002-of-00002.safetensors # 模型权重(部分2)

├── tokenizer.model # 分词器模型

└── tokenizer_config.json # 分词器配置 步骤 4:编写运行脚本

创建run_gemma.py文件,复制以下代码:

from transformers import AutoTokenizer, AutoModelForCausalLM

# 模型路径(替换为你的本地路径)

model_path = "./gemma-3-270m"

# 加载分词器和模型

tokenizer = AutoTokenizer.from_pretrained(model_path)

model = AutoModelForCausalLM.from_pretrained(

model_path,

device_map="cpu", # 强制使用CPU

torch_dtype="auto",

low_cpu_mem_usage=True # 优化内存占用

)

# 测试生成文本

prompt = "用Python写一个计算斐波那契数列的函数"

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(

**inputs,

max_new_tokens=150, # 限制生成长度

temperature=0.7, # 控制随机性(0-1,值越低越确定)

do_sample=True

)

# 输出结果

print(tokenizer.decode(outputs[0], skip_special_tokens=True)) 步骤 5:运行模型并测试

在终端执行脚本:

python run_gemma.py

首次运行会加载模型权重(约需 30 秒至 2 分钟,取决于硬件),之后会输出类似以下内容:

def fibonacci(n):

"""计算第n个斐波那契数(n从0开始)"""

if n <= 0:

return 0

elif n == 1:

return 1

a, b = 0, 1

for _ in range(2, n + 1):

a, b = b, a + b

return b

# 示例:打印前10个斐波那契数

for i in range(10):

print(f"第{i}个斐波那契数:{fibonacci(i)}") 优化本地运行效率的技巧

即使在低配设备上,也可通过以下方法提升体验:

- 减少生成长度:在

generate函数中降低max_new_tokens(如设为 100),减少内存占用。 - 降低温度参数:将

temperature设为 0.3-0.5,模型会优先生成确定性内容,速度更快。 - 启用量化:通过

bitsandbytes库对模型进行 4 位量化,内存占用可减少 50%:

pip install bitsandbytes

加载模型时添加参数:

model = AutoModelForCausalLM.from_pretrained(

model_path,

device_map="cpu",

load_in_4bit=True, # 启用4位量化

quantization_config=BitsAndBytesConfig(load_in_4bit=True)

) 4. 关闭不必要程序:运行模型前关闭其他应用,释放内存和 CPU 资源。

实际应用场景

Gemma 3 270M 虽然参数规模小,但在以下场景中表现亮眼:

- 代码辅助:生成简单函数、解释代码逻辑、补全重复代码块

- 文本处理:批量生成短文本(如邮件主题、标签)、摘要提取

- 学习工具:解释编程概念、生成练习题、翻译技术文档

- 原型开发:快速验证 AI 功能构想,再迁移到更大模型部署

常见问题解决

- 模型加载失败:检查模型路径是否正确,确保权重文件完整(无缺失或损坏)

- 运行卡顿/崩溃:降低生成长度或启用量化,8GB 以下内存建议关闭其他程序

- 输出质量差:尝试调整

temperature参数(如提高至 0.8),或优化提示词(更具体的指令)

总结

Gemma 3 270M 的推出让本地 AI 开发变得触手可及。无需高端硬件,开发者就能在个人设备上体验大语言模型的核心能力,尤其适合快速原型验证、教学演示和低资源环境下的应用开发。其轻量化特性与隐私优势,也为边缘计算、嵌入式设备等场景提供了新可能。

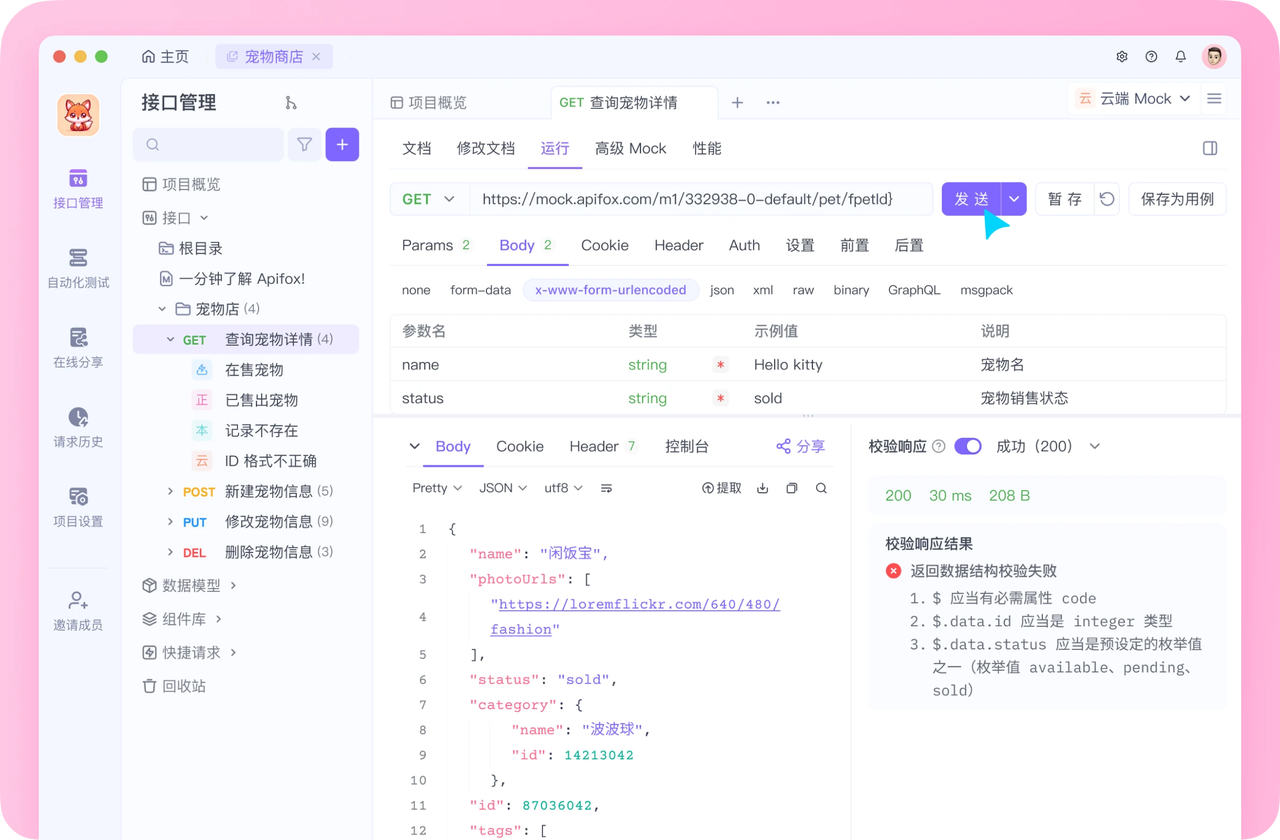

当你利用 Gemma 3 270M 完成本地 AI 功能开发后,若涉及 API 接口的设计、调试与管理,Apifox 能成为你的得力助手。例如,用 Gemma 3 生成 API 调用示例代码后,可在 Apifox 中快速验证接口的正确性,通过可视化界面调试请求参数、查看响应结果;对于需要团队协作的 API 项目,Apifox 能统一管理接口文档,确保前后端开发对齐,让本地模型的能力更顺畅地融入完整的应用开发流程。