开发者始终在寻找能增强 AI 驱动应用的高级工具,而 GPT-5 Pro 凭借出色的复杂推理能力,成为该领域的顶尖模型。通过高算力投入输出精准响应,尤其适合对准确性和深度有高要求的场景。在探索集成方式时,选择能简化流程的工具至关重要。

本文将重点解析两种核心访问渠道:OpenAI 官方平台与 OpenRouter。前者支持直接集成,后者则提供高性价比的路由服务,二者各有优势。通过了解访问前提、认证方式、接口配置及代码示例,同时掌握两大平台的定价结构,助力做出合理决策。

GPT-5 Pro 的核心特性

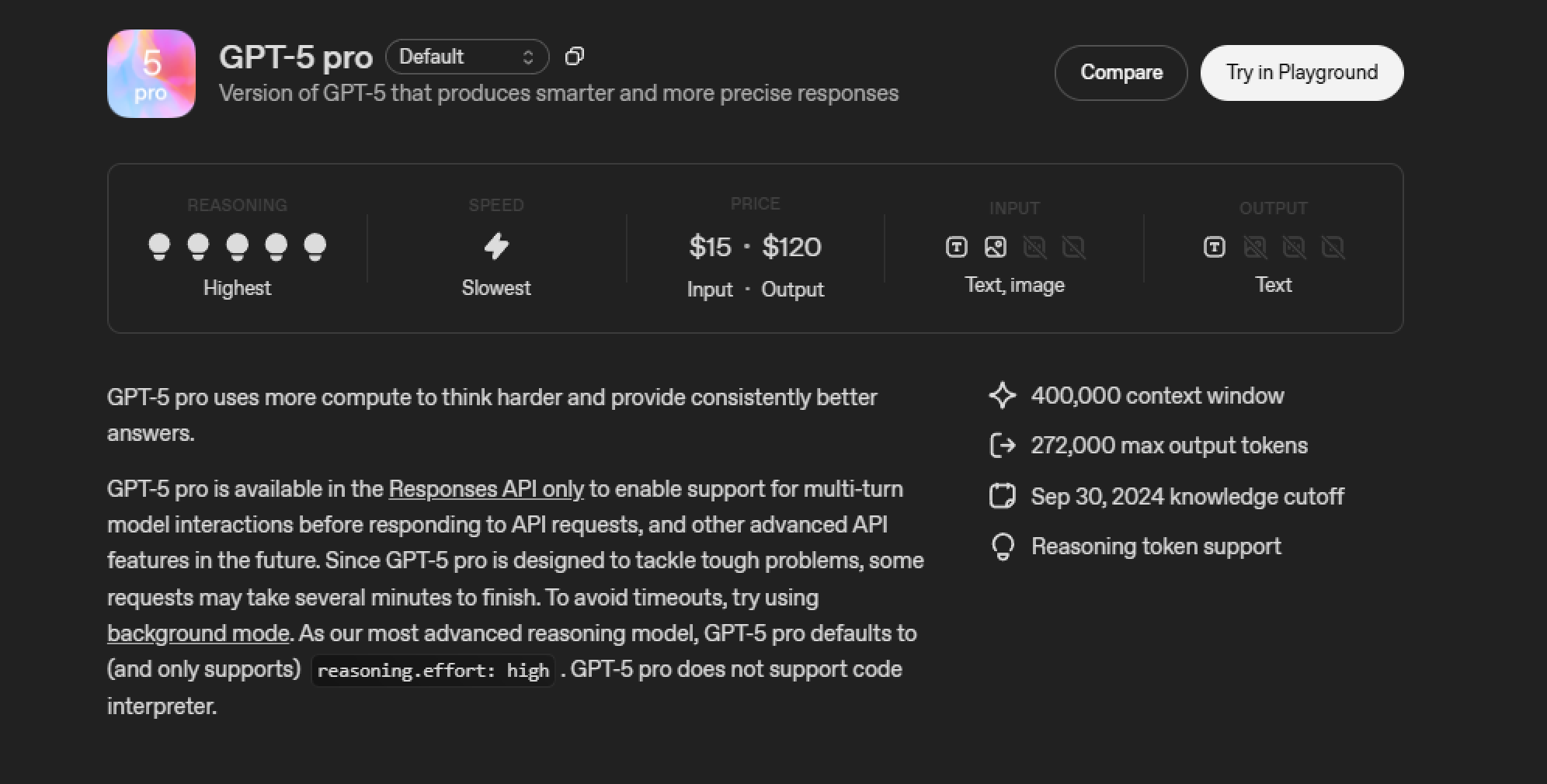

GPT-5 Pro 专为高要求应用场景设计,工程师在开发时着重强化了其推理能力,使其显著区别于前代模型。

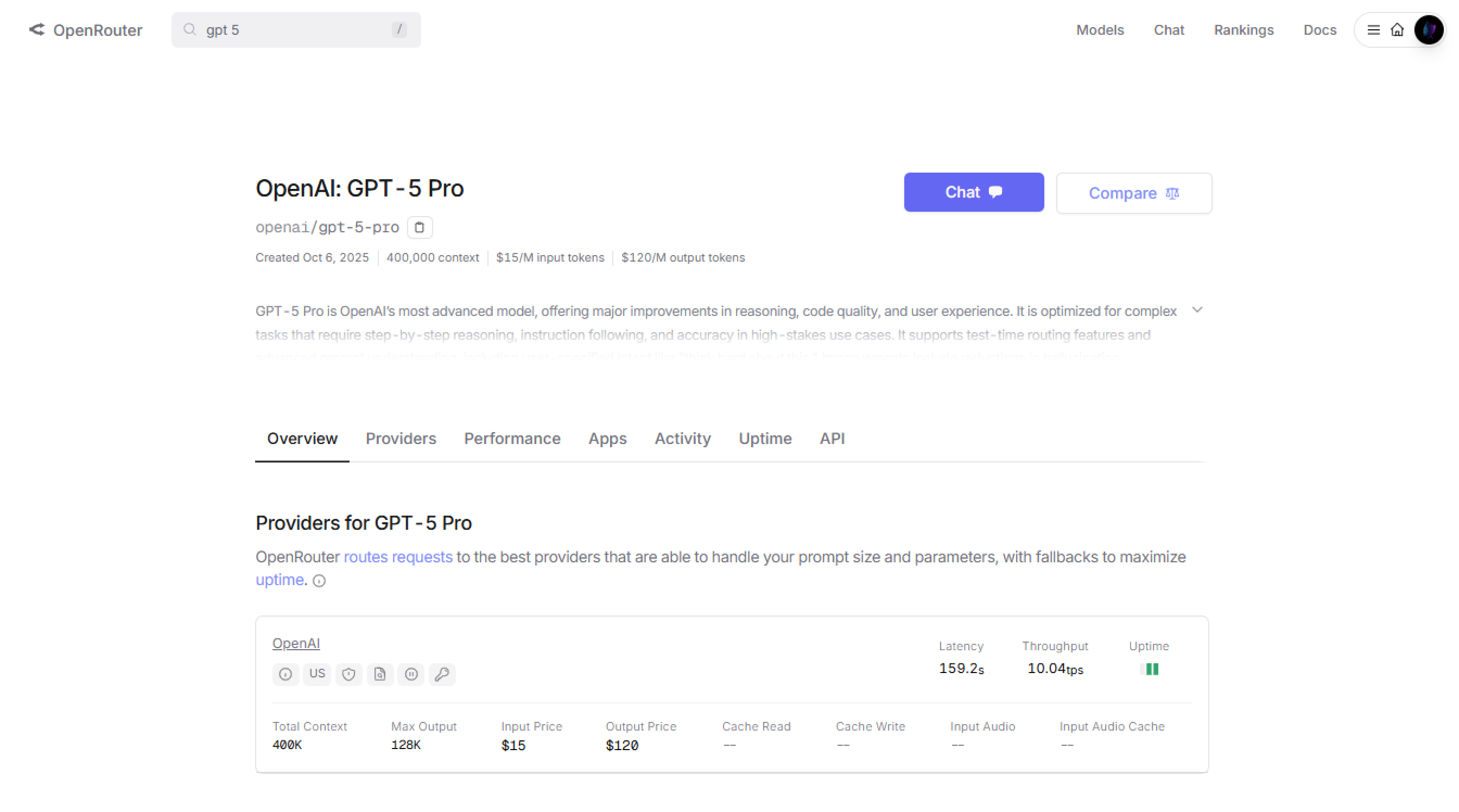

具体而言,该模型默认启用“高推理模式”,确保输出质量的一致性,同时支持 40 万令牌的超大上下文窗口,可处理海量输入内容,输出令牌上限达 27.2 万,能生成详尽的响应结果。

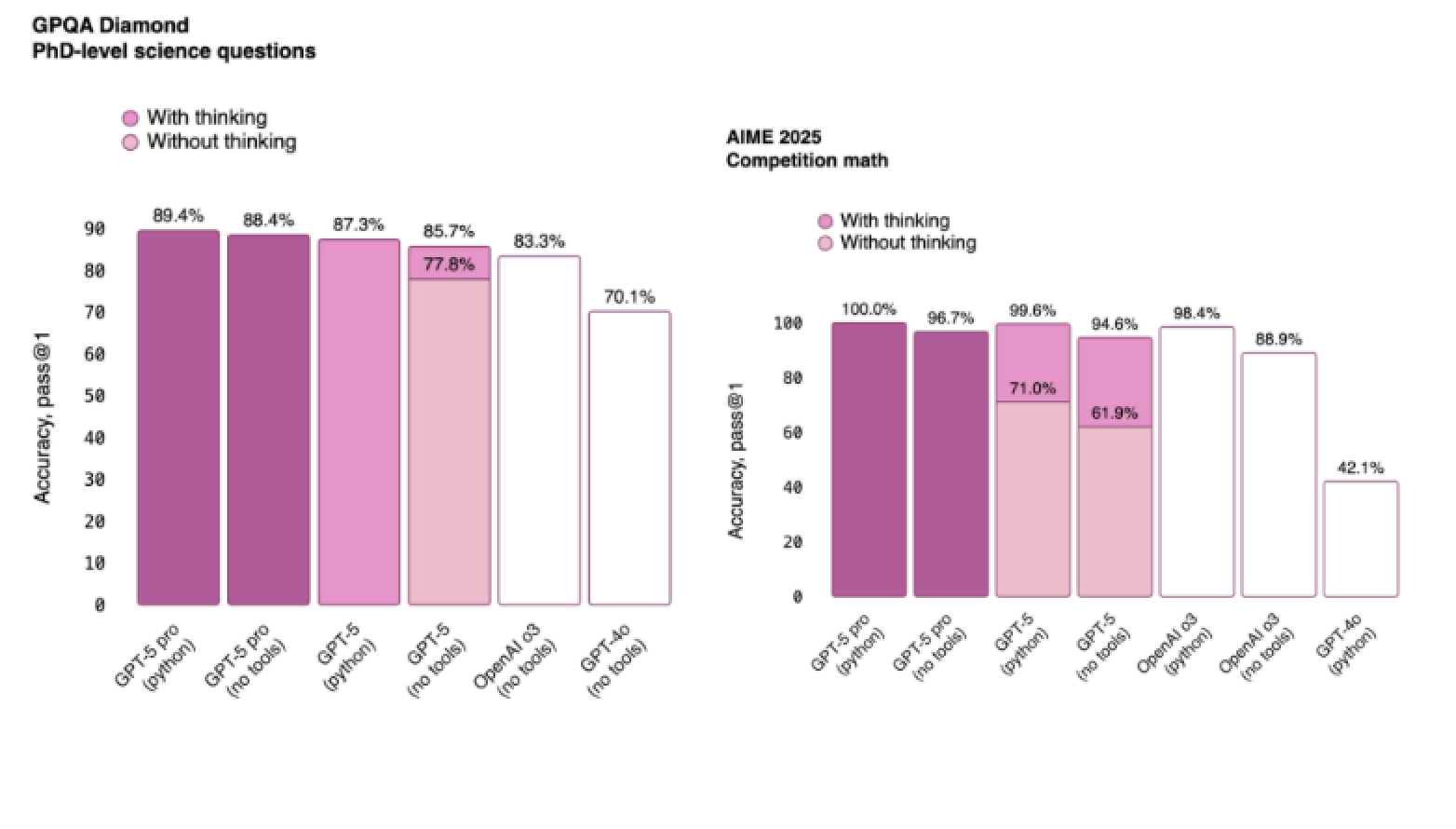

基准测试表现(示例)

测试场景 | 启用推理(With thinking) | 未启用推理(Without thinking) |

|---|---|---|

GPQA 钻石级科学问题 | 89.4% | 83.3% |

AIME 2025 竞赛数学题 | 99.6% | 88.9% |

从模态支持来看,GPT-5 Pro 能高效处理文本输入与输出,同时兼容图像输入,但暂不支持音频或视频格式。开发者会青睐其内置的函数调用与结构化输出功能,这些特性大幅提升了可编程性。

不过需注意的是,流式传输、模型微调与代码解释等功能目前尚未开放。

模型特性 | 支持情况 | 备注 |

|---|---|---|

文本输入/输出 | ✅ 支持 | 默认启用高推理模式 |

图像输入 | ✅ 支持 | 暂不支持图像输出 |

音频/视频 | ❌ 不支持 | 后续版本可能更新 |

函数调用 | ✅ 支持 | 支持结构化参数配置 |

模型微调 | ❌ 不支持 | 仅开放预训练模型访问 |

此外,GPT-5 Pro 的知识截止日期为 2024 年 9 月 30 日,若应用需获取实时信息,需集成网页搜索等工具补足时效性。综合来看,这些特性使 GPT-5 Pro 成为技术项目的可靠选择,无论是代码生成还是分析推理场景均能胜任。

访问 GPT-5 Pro API 的前提条件

在集成 GPT-5 Pro 前,需完成以下准备工作:

1. 创建平台账户

根据选择的渠道注册账号,OpenAI 需访问开发者平台注册。

OpenRouter 则需在其官网完成注册。

二者均需生成 API 密钥用于后续认证。

2. 组织验证(OpenAI 专属)

部分模型访问需验证组织信息,这一步常被开发者忽略,可能导致访问被拒绝,需在 OpenAI 控制台完成组织信息补全。

3. 合规性检查

确保符合平台使用政策,尤其是速率限制规则(不同层级用户的请求频率与令牌配额不同),避免因违规导致账号受限。

4. 技术储备

掌握 Python 或 JavaScript 等编程语言(API 调用依赖这些语言),安装对应 SDK(如 OpenAI SDK)简化交互;需注意兼容性,GPT-5 Pro 主要适配 Responses API 等特定接口。

5. 预算规划

采用令牌计价模式,需提前预估用量避免超支,建议通过平台仪表盘实时监控消耗情况。

完成上述准备后,即可为 API 访问搭建稳固基础。

通过 OpenAI 平台访问 GPT-5 Pro

OpenAI 提供 GPT-5 Pro 的直接访问渠道,集成流程简洁高效,具体步骤如下:

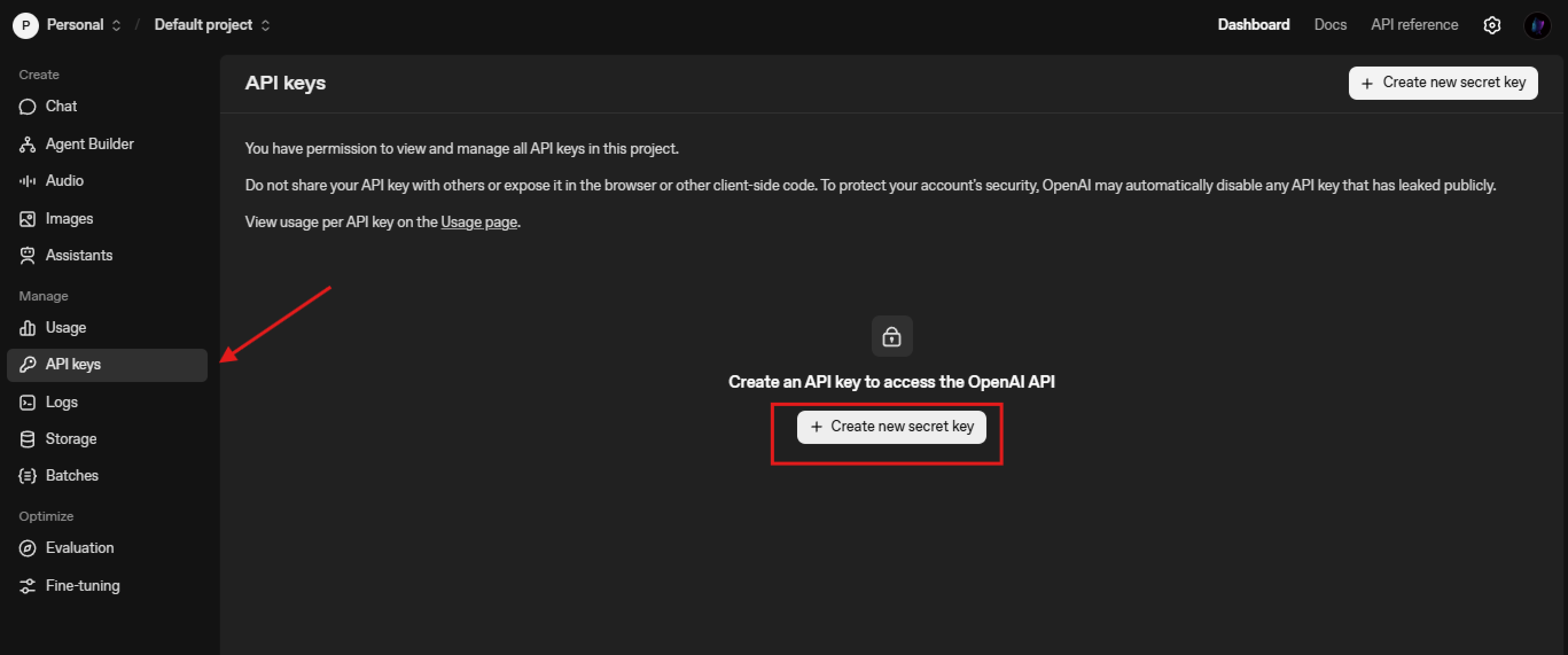

1. 获取 API 密钥

登录 OpenAI 控制台,进入“API 密钥”板块,点击“生成新密钥”,生成后需立即安全存储(密钥仅显示一次,丢失需重新生成)。

2. 请求认证配置

通过请求头携带密钥完成认证,HTTP 调用需包含以下头部信息:

Authorization: Bearer YOUR_API_KEY

Content-Type: application/json该步骤可防止未授权访问,确保通信安全。

3. 接口选择与使用

GPT-5 Pro 主要通过 Responses API(接口/v1/responses)提供服务,该接口适配多轮交互场景;此外,/v1/chat/completions适用于标准对话,/v1/embeddings用于生成向量表示,开发者需根据任务需求选择接口。

以基础调用为例,构造 POST 请求时需指定模型为“gpt-5-pro”并传入提示信息,示例如下:

POST https://api.openai.com/v1/responses

{

"model": "gpt-5-pro",

"messages": [{"role": "user", "content": "解释量子计算的核心原理"}],

"reasoning": {"effort": "high"}

}需注意,复杂查询可能耗时数分钟,建议启用“背景模式”(background mode)避免请求超时。

4. 工具集成拓展

可在请求体中指定网页搜索、文件搜索等工具,增强模型能力。例如添加网页搜索工具:

"tools": [{"type": "web_search", "parameters": {"query": "2025量子计算最新进展"}}]OpenAI 集成代码示例

1. Python 实现(基于 OpenAI SDK)

首先安装 SDK:

pip install openai初始化客户端并调用 API:

from openai import OpenAI

# 初始化客户端(替换为你的API密钥)

client = OpenAI(api_key="YOUR_API_KEY")

# 发起GPT-5 Pro请求

response = client.chat.completions.create(

model="gpt-5-pro",

messages=[{"role": "user", "content": "解决这个数学问题:若x²+3x-10=0,求x的值"}],

reasoning={"effort": "high"} # 启用高推理模式

)

# 输出结果

print("GPT-5 Pro响应:", response.choices[0].message.content)2. JavaScript 实现(基于 fetch API)

// 配置请求参数

const apiKey = "YOUR_API_KEY";

const url = "https://api.openai.com/v1/chat/completions";

const data = {

model: "gpt-5-pro",

messages: [{"role": "user", "content": "生成一个简单的Python排序函数"}],

reasoning: {"effort": "high"}

};

// 发起请求

fetch(url, {

method: "POST",

headers: {

"Authorization": `Bearer ${apiKey}`,

"Content-Type": "application/json"

},

body: JSON.stringify(data)

})

.then(res => res.json())

.then(result => {

console.log("GPT-5 Pro响应:", result.choices[0].message.content);

})

.catch(err => console.error("请求错误:", err));3. 错误处理与监控

建议通过try-except(Python)或catch(JavaScript)捕获异常,并记录速率限制相关响应头(如X-RateLimit-Remaining),实时监控用量:

try:

response = client.chat.completions.create(...)

# 记录剩余令牌配额

print("剩余令牌:", response.headers.get("X-RateLimit-Remaining"))

except Exception as e:

print("调用失败:", str(e))OpenAI 平台的 GPT-5 Pro 定价详情

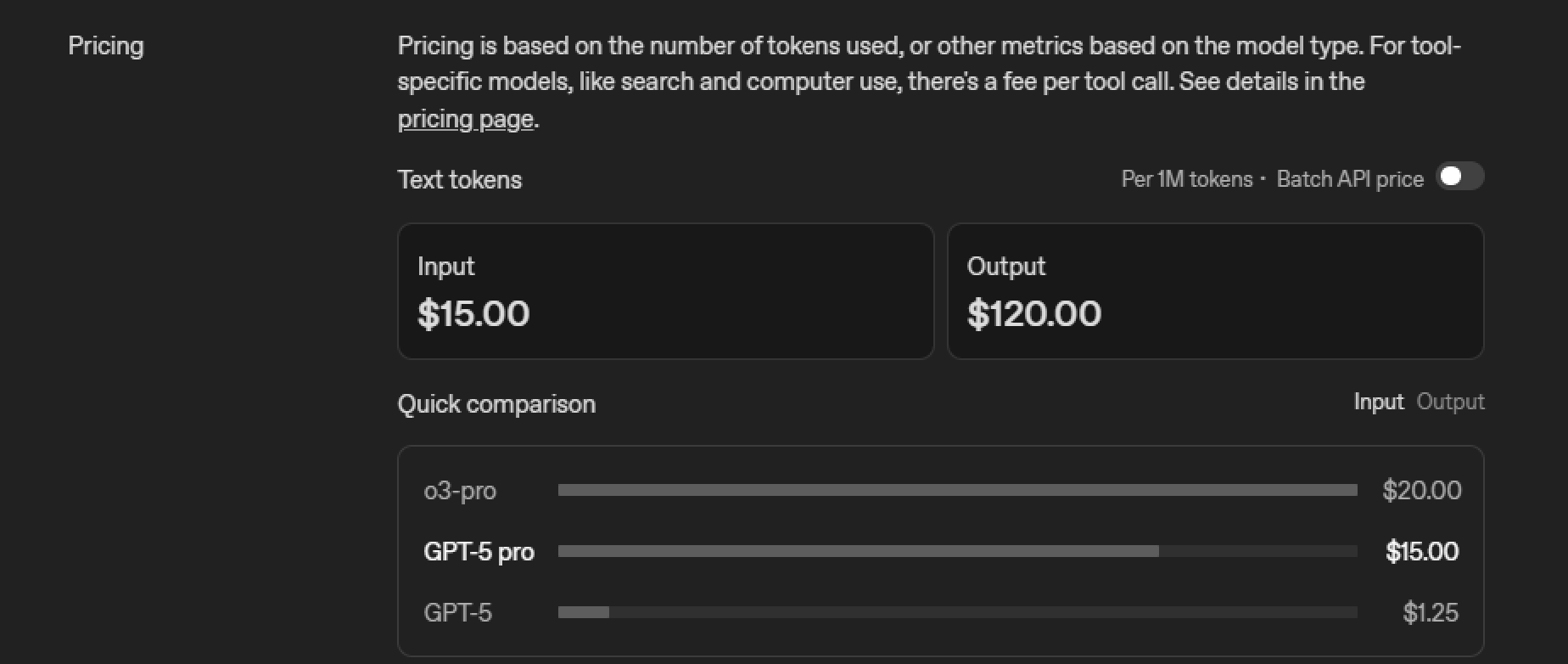

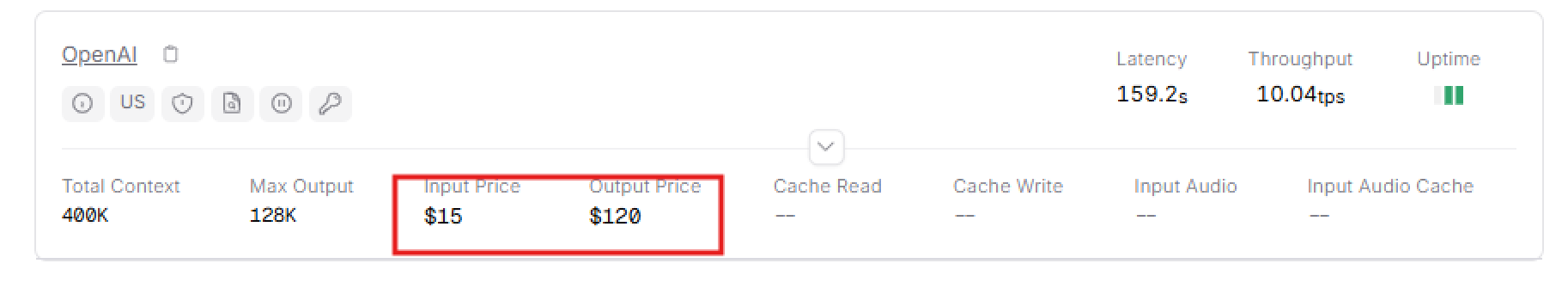

OpenAI 采用“按令牌计价”模式,GPT-5 Pro 的具体价格如下:

计费项 | 价格(每百万令牌) | 备注 |

|---|---|---|

输入令牌(Input) | $15 | 批量 API 调用价格相同 |

输出令牌(Output) | $120 | 生成详细响应时成本较高 |

工具调用(如网页搜索) | 单独计费 | 按工具类型收取额外费用 |

对比同类模型,GPT-5(非 Pro 版)的输入令牌价格仅为 $1.25/百万,可见 GPT-5 Pro 定位高端场景。速率限制与用户层级绑定,间接影响成本:

- Tier 1(基础层级):每分钟 500 次请求,每分钟 3 万令牌

- Tier 5(企业层级):每分钟 1 万次请求,每分钟 3000 万令牌,适合高并发需求

开发者可通过“精简提示词”优化成本(如避免冗余描述),并借助 OpenAI 仪表盘实时追踪支出,确保性价比最大化。

通过 OpenRouter 访问 GPT-5 Pro 的优势

OpenRouter 通过“跨平台请求路由”简化 GPT-5 Pro 访问,核心优势如下:

- 统一 API 兼容:支持 OpenAI SDK 直接调用,无需修改代码适配,仅需更换基础 URL,降低迁移成本

- 自动故障转移(Fallback):峰值负载时自动路由至可用提供商,保障服务可用性,尤其适合生产环境

- 成本优化:不定期推出折扣活动(如 GPT-5 系列模型 5 折),降低实验与部署成本

- 多模型聚合:集成超 400 款模型,切换模型无需修改代码,仅需指定“openai/gpt-5-pro”即可调用

- 灵活计费:支持“自带密钥(BYOK)”模式,免费额度内无额外费用,超额后仅收取 5%服务费,适合成本敏感型项目

OpenRouter 的访问设置步骤

1. 账户准备

注册 OpenRouter 账号后,进入“Credits”页面充值(用量从余额中扣除),建议根据预估用量小额充值测试

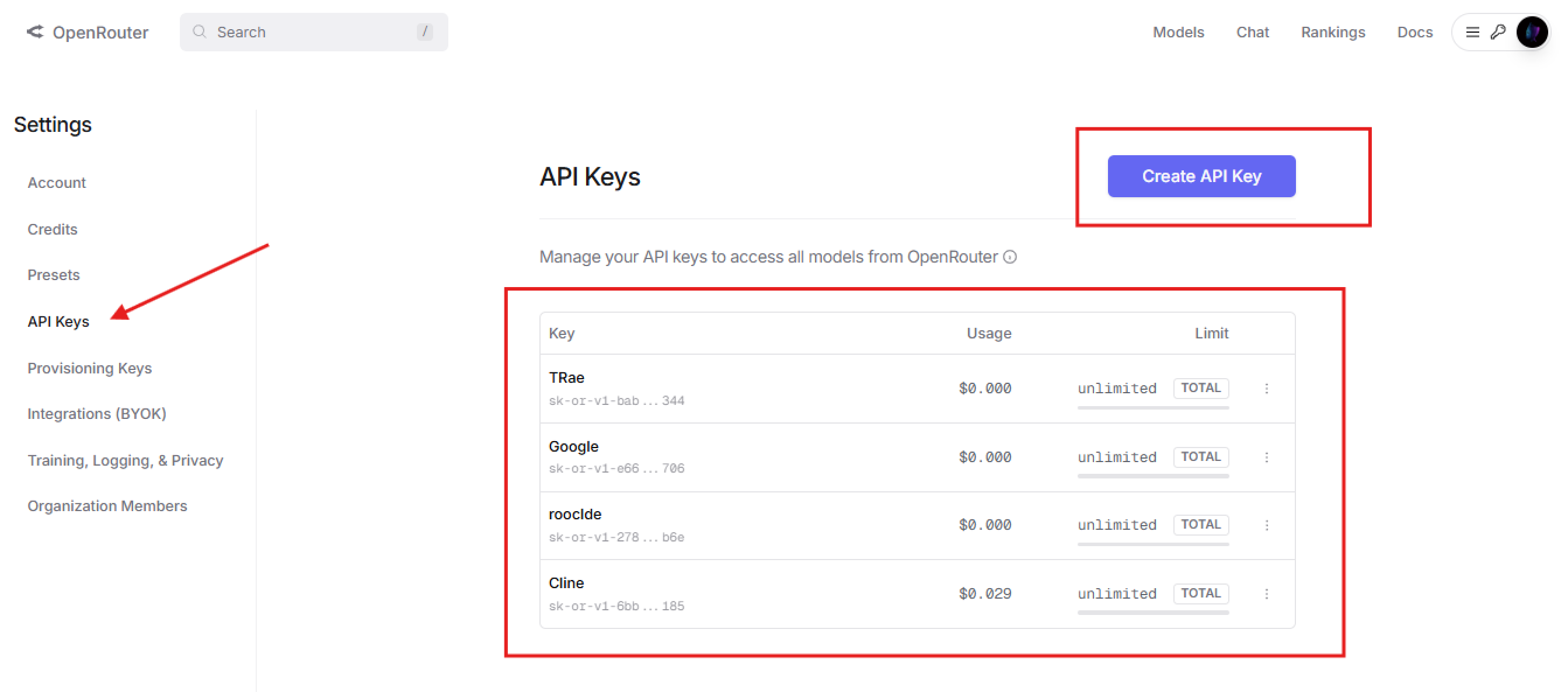

2. 生成 API 密钥

在控制台“API Keys”板块生成密钥,该密钥需替代 OpenAI 密钥使用,确保安全存储

3. 认证与路由配置

- 认证方式:与 OpenAI 一致,通过

Authorization: Bearer YOUR_OPENROUTER_KEY完成请求头配置 - 路由偏好:可选添加

HTTP-Referer头标注应用来源(用于平台排行榜),非强制但建议配置 - 模型变体选择:通过模型名后缀优化性能,如“openai/gpt-5-pro:floor”(成本优先)或“openai/gpt-5-pro:nitro”(速度优先)

OpenRouter 集成代码示例

OpenRouter 的 API 设计与 OpenAI 兼容,代码仅需调整基础 URL,示例如下:

1. Python 实现

from openai import OpenAI

# 初始化客户端(指定OpenRouter基础URL)

client = OpenAI(

base_url="https://openrouter.ai/api/v1",

api_key="YOUR_OPENROUTER_KEY"

)

# 调用GPT-5 Pro

response = client.chat.completions.create(

model="openai/gpt-5-pro",

messages=[{"role": "user", "content": "生成一个简易网页应用的HTML代码"}]

)

print("响应结果:", response.choices[0].message.content)2. JavaScript 实现

const apiKey = "YOUR_OPENROUTER_KEY";

const url = "https://openrouter.ai/api/v1/chat/completions"; // 调整URL

const data = {

model: "openai/gpt-5-pro",

messages: [{"role": "user", "content": "解释REST API的设计原则"}]

};

fetch(url, {

method: "POST",

headers: {

"Authorization": `Bearer ${apiKey}`,

"Content-Type": "application/json"

},

body: JSON.stringify(data)

})

.then(res => res.json())

.then(result => console.log(result.choices[0].message.content))

.catch(err => console.error(err));若需启用故障转移,可在请求头中指定多个提供商,OpenRouter 会自动选择最优渠道。

OpenRouter 的 GPT-5 Pro 定价详情

OpenRouter 的定价随模型与提供商波动,GPT-5 Pro 的常规价格与 OpenAI 一致(输入 $15/百万令牌,输出 $120/百万令牌),但有以下优化:

- 限时折扣:促销期间部分模型可享 5 折,需关注平台“Promotions”板块

- 免费额度:部分轻量模型提供免费调用额度,但 GPT-5 Pro 需充值后使用

- BYOK 模式:自带 OpenAI 密钥时,免费额度为每月 100 万令牌,超额后收取 5%服务费,成本低于直接通过 OpenAI 调用

建议在 OpenRouter“Models”页面查看实时价格,透明的计费方式便于预算规划。

OpenAI 与 OpenRouter 的对比选择

对比维度 | OpenAI | OpenRouter |

|---|---|---|

访问方式 | 直接访问,专属接口 | 路由访问,兼容 OpenAI SDK |

核心优势 | 独家特性(如快照版本锁定) | 故障转移、多模型聚合、成本优化 |

定价模式 | 固定令牌价,无额外费用 | 基础价+可选服务费,含折扣活动 |

适用场景 | 需稳定专属集成的企业项目 | 成本敏感、需多模型切换的场景 |

技术门槛 | 需单独适配,文档完善 | 零代码适配,学习成本低 |

选择建议:若需精准控制与独家功能,优先选 OpenAI;若追求灵活性与成本优化,OpenRouter 更合适。

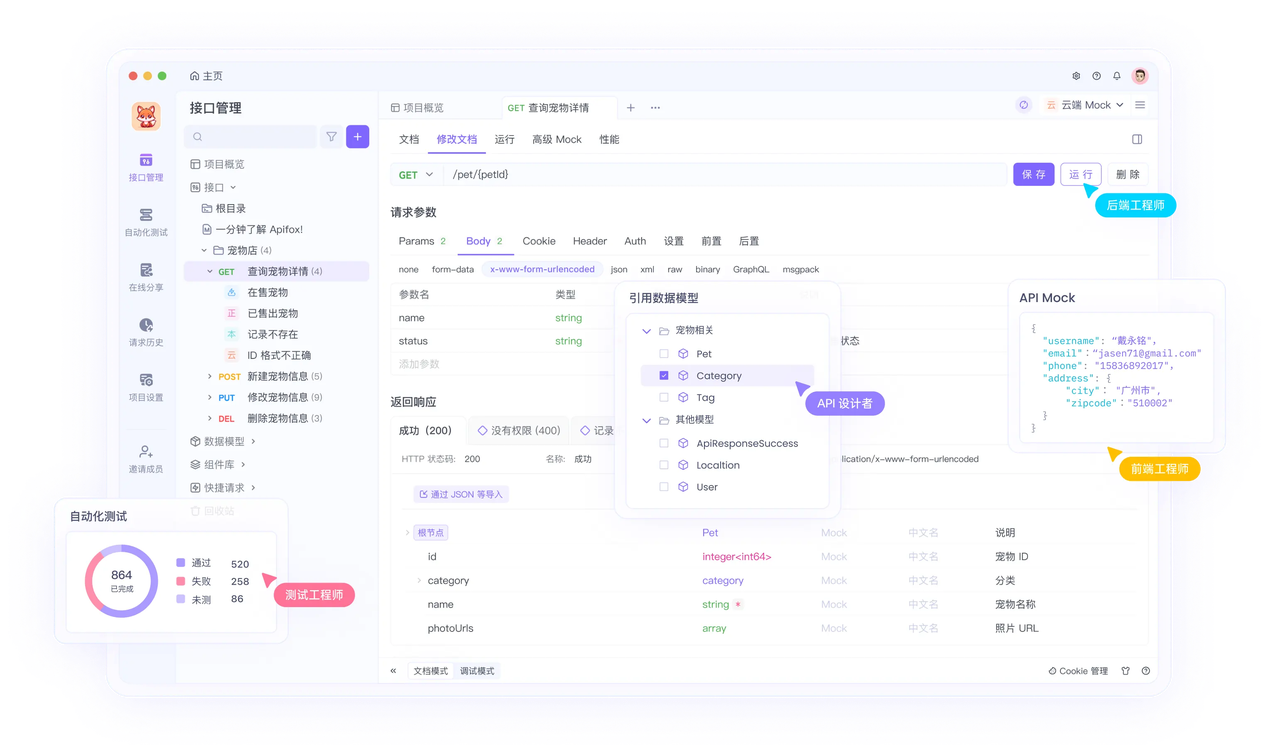

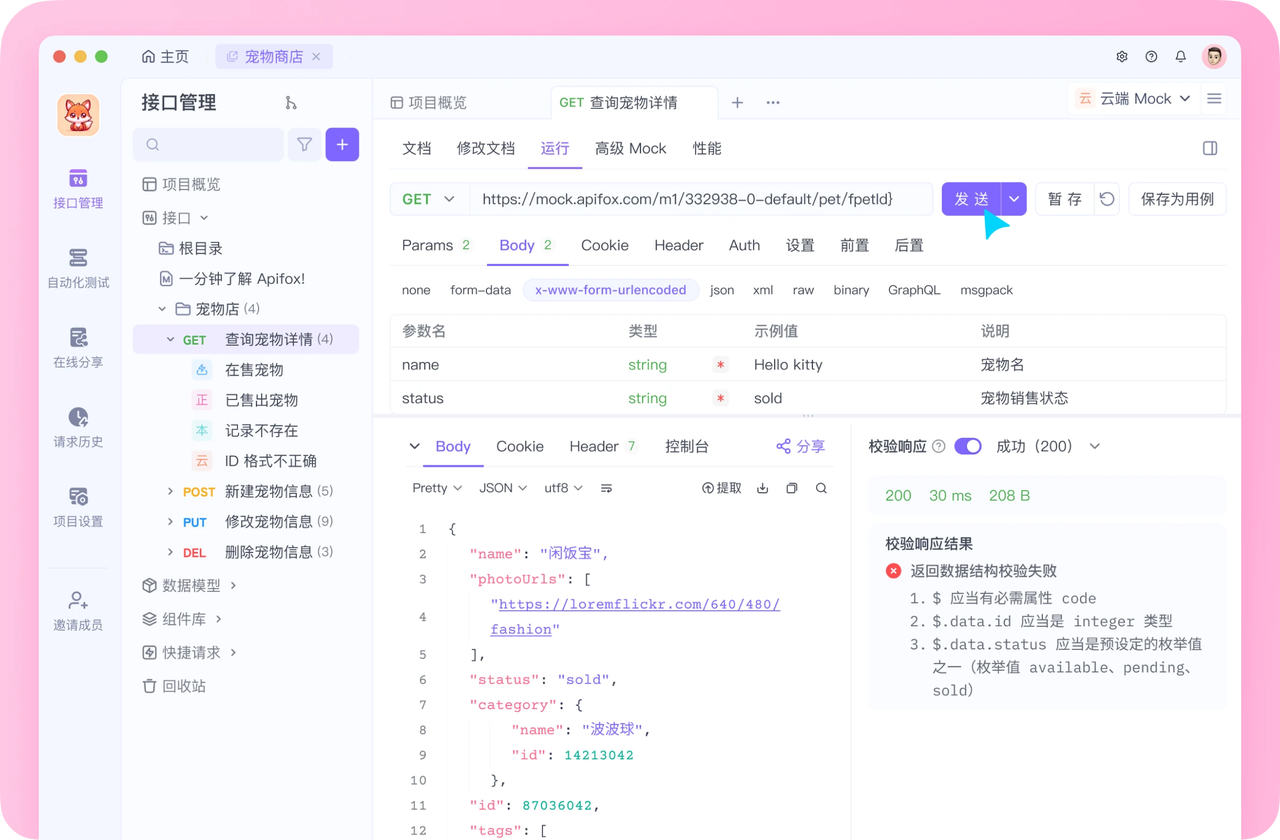

用 Apifox 高效测试 GPT-5 Pro API

Apifox 能简化 GPT-5 Pro 的 API 交互流程,是测试与集成的关键工具,核心功能包括:

1. 结构化请求管理

创建 API 集合归类 GPT-5 Pro 的不同接口(如/v1/responses、/v1/chat/completions),支持参数模板化(如将 API 密钥存入环境变量,避免硬编码)。

2. 自动化测试生成

导入 OpenAI 的 OpenAPI 规范,Apifox 会自动生成测试用例,覆盖“正常请求”“令牌过期”“参数错误”等场景,无需手动编写断言。例如测试/v1/responses接口时,可自动验证“响应包含 choices 字段”“状态码为 200”。

3. 模拟服务与离线开发

通过 Apifox 的 Mock 功能模拟 GPT-5 Pro 的响应格式(如指定推理结果、令牌消耗),无需调用真实 API 即可开展前端开发,避免测试阶段消耗配额。

4. 调试与协作

- 详细日志:捕获完整请求/响应数据,包括 headers、耗时、令牌用量,快速定位“401 认证失败”“429 速率超限”等问题

- 团队共享:将测试集合与文档同步给团队,支持评论协作,统一测试标准

免费下载 Apifox 即可解锁上述功能,大幅提升 GPT-5 Pro 的集成效率。

GPT-5 Pro API 的使用最佳实践

- 提示词优化:保持简洁性(如用“生成 Python 快速排序函数”替代冗长描述),减少输入令牌消耗;高推理模式仅用于复杂任务(如法律合同分析),避免浪费算力

- 错误处理:对 transient 错误(如网络波动)实现重试机制,重试间隔建议指数递增(如 1s→2s→4s);捕获速率限制错误时,优先升级用户层级而非频繁重试

- 安全存储:API 密钥通过环境变量或配置文件管理,禁止暴露在前端代码或版本控制系统中;定期轮换密钥(如每月一次)

- 批量处理:将多个小请求合并为批量调用(如通过

/v1/responses的批量参数),减少 HTTP 请求次数,降低延迟

潜在挑战与解决方案

挑战 | 解决方案 |

|---|---|

复杂查询超时 | 启用背景模式(background: true),通过轮询获取结果;拆分大任务为子请求 |

速率限制约束 | 监控 X-RateLimit-Remaining头,动态调整请求频率;升级至更高用户层级 |

成本超支 | 使用 Apifox 的“令牌用量预估”功能;优先在 OpenRouter 促销期测试 |

响应格式不一致 | 通过 Apifox 的“响应断言”强制校验结构;在请求中指定 response_format: json |

高级集成技巧

- 异步响应处理:通过 webhook 接收 GPT-5 Pro 的异步结果,避免长轮询占用资源,尤其适合耗时超 5 分钟的任务(如多文档分析)

- 智能体构建:结合函数调用功能搭建 AI 智能体,让 GPT-5 Pro 自主选择工具(如“查询天气→调用天气 API→整理结果”),无需手动触发

- 负载均衡:跨 OpenAI 与 OpenRouter 部署,通过 Apifox 的“流量路由”功能根据成本/可用性动态切换渠道,保障高并发场景稳定

总结

访问 GPT-5 Pro API 能为应用注入强大的推理能力,通过 OpenAI 与 OpenRouter 两大渠道,开发者可根据需求选择适配方案。而 Apifox 作为测试与集成工具,能简化流程、降低成本,是 GPT-5 Pro 落地的重要助力。

在实际项目中,Apifox 与 GPT-5 Pro 的协同价值可进一步延伸:

- 用 GPT-5 Pro 生成 API 调试代码后,Apifox 可立即验证代码正确性,自动生成压力测试场景(如模拟 100 并发请求),监控响应延迟与令牌消耗

- 若需优化 API 性能,Apifox 的“参数对比测试”能快速定位“推理模式”“提示词长度”对响应速度的影响,帮助找到“性能-成本”平衡点

借助这套组合,开发者能高效释放 GPT-5 Pro 的能力,打造更智能的应用。

立即行动,结合本文指南接入 GPT-5 Pro API,并用 Apifox 保障集成质量,让 AI 驱动的创新更快落地!