5 月 13 日,一款名为 GPT-4o 的新 ChatGPT 模型发布了。与之前的版本相比,GPT-4o 的响应时间提高了一倍,能理解文本、图像、音频和视频。在本文中,我们将全面讲解 OpenAI 最新模型 GPT-4o 的基本信息,并介绍如何将 GPT-4o API 集成到自己的服务中。

Apifox 也是一个完全免费的工具,可以点击按钮了解详情。

什么是 GPT-4o?

GPT-4o 是 OpenAI 于 5 月 13 日宣布的最新 AI 模型。 “4o”中的“o”代表“omni”,意思是“全方位的”。与 ChatGPT 基于文本和图像的交互不同,GPT-4o 允许使用文本、音频、图像和视频的组合与其进行交互。

更多详情可以访问官网:https://openai.com/index/hello-gpt-4o/

GPT-4o 的特点

那么,OpenAI 的最新模型 GPT-4o 与之前的模型相比有哪些特点呢?

响应时间缩短

根据 OpenAI 的说法,GPT-4 与人类对话需要三个步骤:

- 将语音转换为文本

- 生成响应文本

- 将文本转换为语音

在之前的模型中,GPT-3.5 平均延迟为 2.8 秒,GPT-4 平均延迟为 5.4 秒。然而,最新的 GPT-4o 可以在短短 2.32 秒内做出响应,平均响应时间为 3.20 秒,几乎与人类的反应速度相同。也就是说,使用最新的 GPT-4o 模型与 AI 实现近乎实时的交互。

理解音频情感标记

以前的 GPT 模型无法识别说话者的语气或背景噪音,导致对话时常常丢失一些信息。然而随着 GPT-4o 的推出,它现在可以理解说话者的音频标记,或者说是情感,使其更加像人类。

Token 花费减少

此外,GPT-4o 压缩了日语等 20 种语言使用的标记数量。比如日语,意味着在日语中使用 ChatGPT 时,将使用更少的 Tokens。

比如,交互“你好,我叫 GPT-4o,我是一种新型语言模型,很高兴认识你”,使用的 Tokens 数量从 37 个减少到 24 个。

基本免费

GPT-4o 发布后,之前付费的服务(例如 GPT、GPT Store 和 GPT-4)将免费提供。

提供桌面客户端

ChatGPT 迄今为止仅在线提供,但在 GPT-4o 模型公告中发布了新的 macOS ChatGPT 桌面应用程序。 Windows 应用程序预计也将在今年下半年发布。

GPT-4o API 的使用

在开发 Web 应用程序时,使用 API 将 AI 功能集成到自己的服务中非常方便。随着 GPT-4o 模型的发布,我们也可以使用 API 将 GPT-4o 模型的出色功能引入到自己的服务中。那么我们需要知道,GPT-4o API 可以用吗?它要多少钱?

GPT-4o API 可用吗?

根据 OpenAI 的最新信息,GPT-4o 模型 API 已经在 Chat Completions API、Assistants API 和 Batch API 中作为文本和视觉模型提供。

GPT-4o API 升级

与之前的 ChatGPT 模型 API 相比,GPT-4o API 具有以下优势:

- 更智能:在文本分析、推理、编程能力上,提供 GPT-4 Turbo 级别的性能,在多语言、音频和视觉能力上设立了新的高标准。

- 响应速度提升:与 GPT-4 Turbo 相比,响应速度提升 2 倍。

- 价格减半:无论是输入还是输出标记,价格都比 GPT-4 Turbo 便宜 50%。

- 速率限制值提高: 速度限制比 GPT-4 Turbo 高出 5 倍,最高可达每分钟 1000 万个 Tokens。

- 视觉能力优化:视觉能力全面优化。

- 非英语语言处理能力提升:优化了对非英语语言的处理,在标记化非英语文本时更为高效。

GPT-4o API 定价

那么,使用这个最新的 GPT-4o API 模型需要花多少钱呢?

根据 OpenAI API 官方网站的信息,GPT-4o 比 GPT-4 Turbo 更快且更具性价比,同时具备更强大的视觉能力。它具有 128K 的上下文,涵盖截至 2023 年 10 月的知识。而且它的价格只有 GPT-4 Turbo 的一半。

具体定价方案如下:

根据 OpenAI API 定价页面,GPT-4o 文本输入和输出的成本为:

- 输入:5 美元 / 1M tokens

- 输出:15 美元 / 1M tokens

视觉处理的成本是基于图像的宽度和高度计算的。

下图的示例中,处理一张 1150px × 150px 的图像成本为 0.001275 美元,而且还可以选择低分辨率选项。

所以,无论是输入、输出还是图像生成,使用 GPT-4o API 的成本都是 GPT-4 Turbo 的一半。

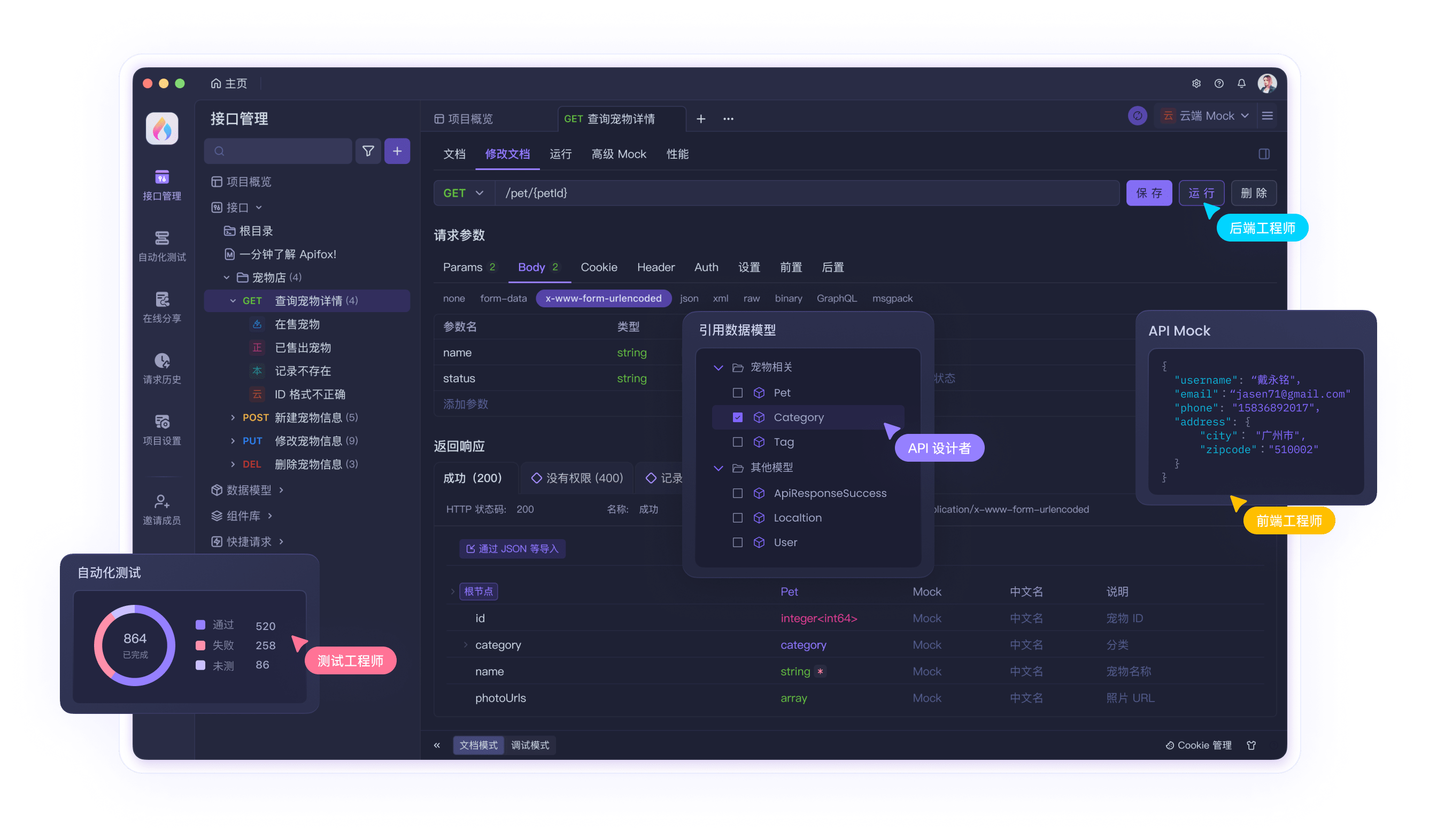

使用 Apifox 管理 GPT-4o API

使用 GPT-4o API 时,API 调试和管理等任务就非常重要。

通过使用超便捷的 API 管理工具 Apifox,你可以更方便、更高效地管理任何 API。由于 GPT-4o API 已经可用,你可以访问 Apifox 上的 API Hub 并轻松访问 OpenAI API 项目,将 GPT-4o API 项目克隆到自己的项目中,查看和调试 GPT-4o API,并使用 Apifox 方便地进行管理。

获取 OpenAI API 密钥使用 GPT-4o API

要开始使用 GPT-4o API,你首先需要获取 OpenAI API 密钥。让我们按照下面的教程获取你的 OpenAI API 密钥。

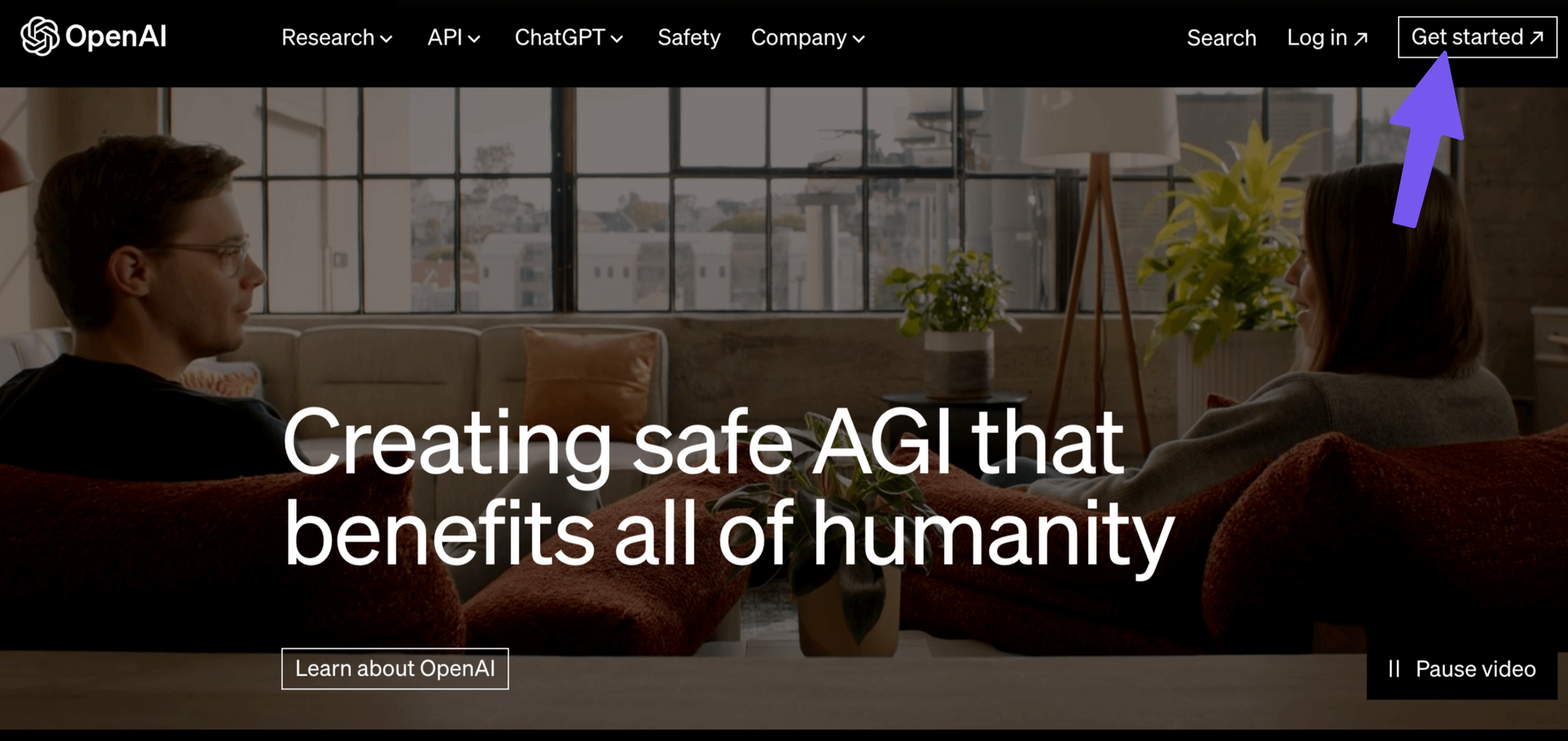

1. 注册 OpenAI 账户

首先需要创建一个 OpenAI 帐户。访问 OpenAI 官网,点击右上角“Get Started”按钮创建账户。

2.获取 OpenAI API 密钥

创建 OpenAI 帐户后,你需要获取用于身份验证的 API 密钥,有了它才能使用 GPT-4o API 。

- 访问 OpenAI 上的 API 密钥页面并使用你的帐户登录(如果没有帐户,则创建一个新帐户)。

- 点击“Create new secret key”按钮生成新的 API 密钥。

生成 API 密钥后,会立即显示在屏幕上,你一定要记录并安全存储它,因为后面你将无法再次查看它。

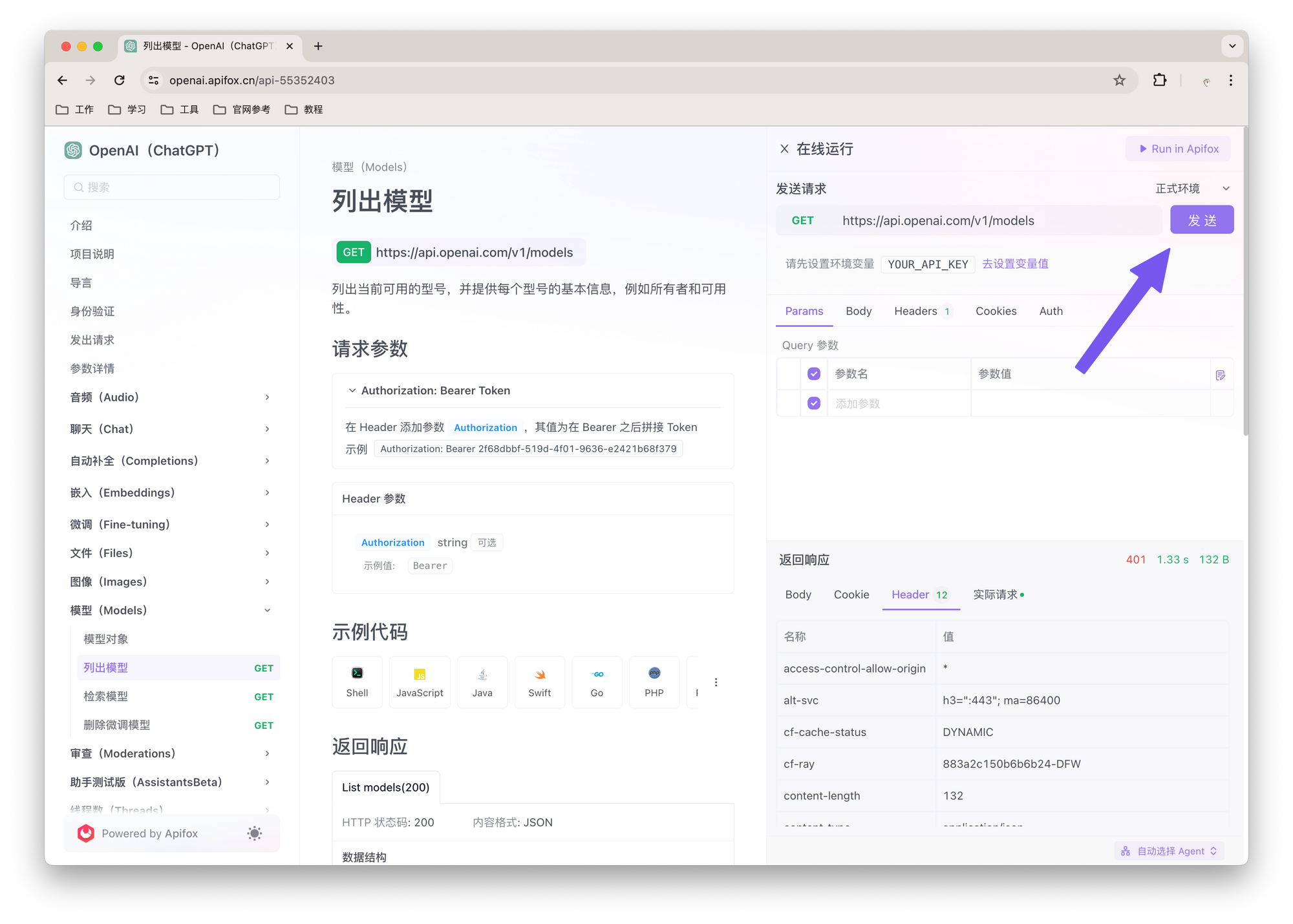

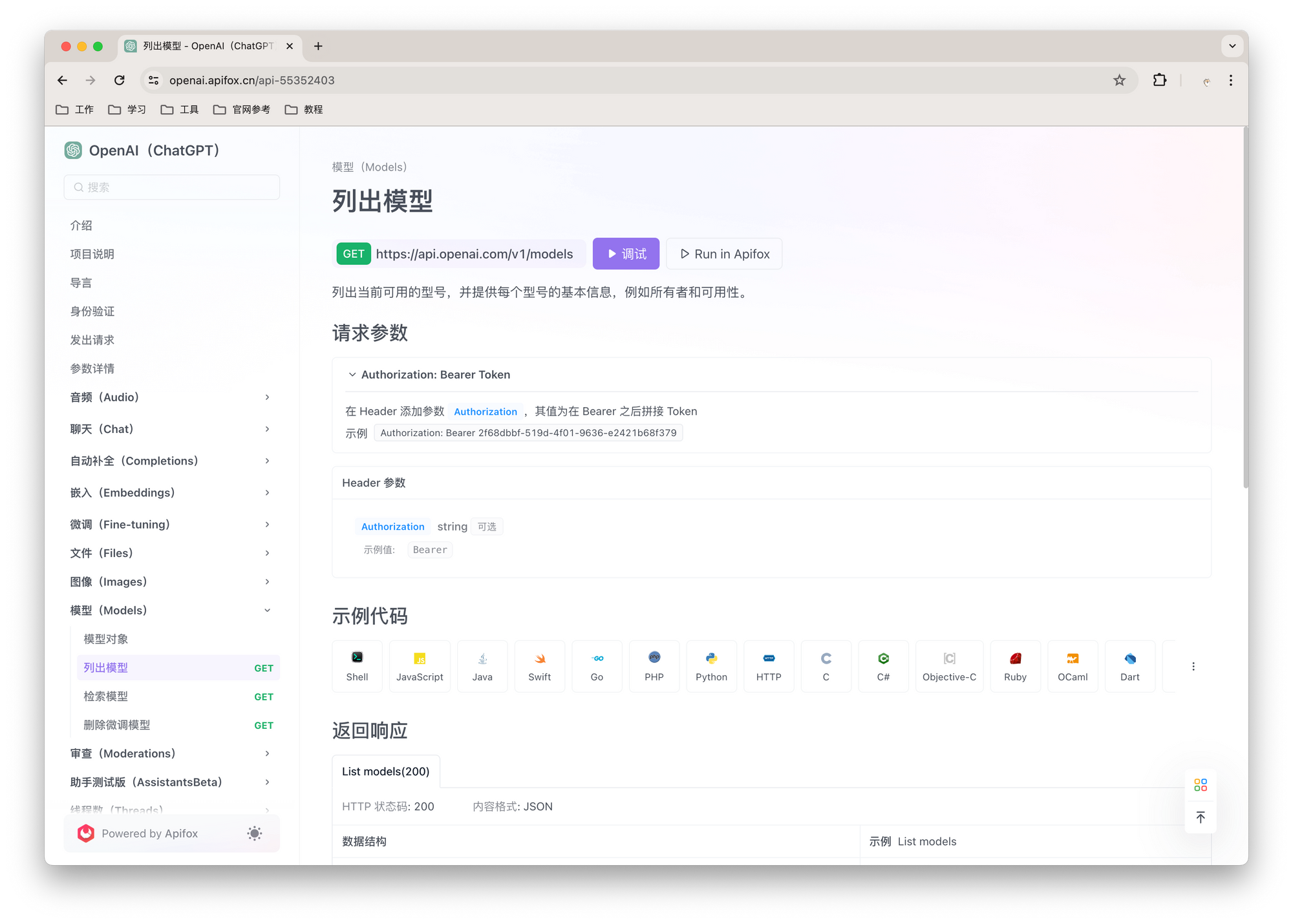

方便地测试和管理 GPT-4o API

对于想调用 GPT-4o API 的用户来说,Apifox 是一个非常方便的工具。 Apifox 有一个 OpenAI API 项目,涵盖了 OpenAI 提供的所有 API。从 OpenAI API 项目的左侧菜单中选择聊天(Chat),在请求 Body 里面将模型指定为“gpt-4o”,例如 "model":"gpt-4o" ,这样就可以开始使用 GPT-4o API。

实战演示:将 GPT-4o API 与 Apifox 结合使用

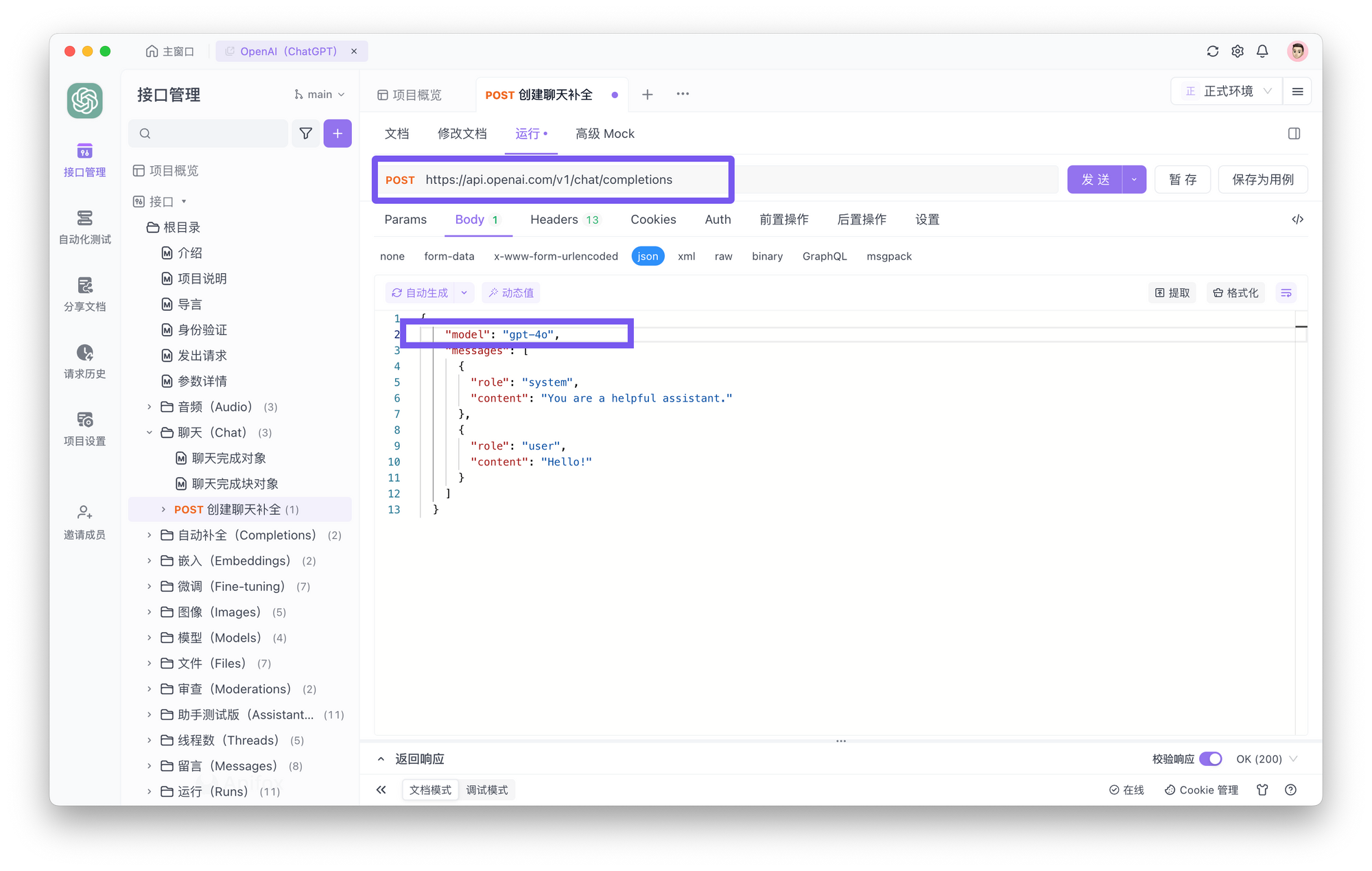

在 Apifox 上访问 OpenAI API 项目时,你可以按照以下步骤轻松测试 OpenAI API,了解如何将 GPT-4o 与聊天完成 API 结合使用。

访问 Apifox 上的 OpenAI API 项目,从左侧菜单中选择 Chat Completions API ,然后根据 ChatGPT 规范输入 HTTP 方法和端点 URL。

在“Body”选项卡中,以 JSON 格式写入要发送到 ChatGPT 的消息。需要注意的是,使用 GPT-4o,需要通过包含 "model":"gpt-4o" 将模型指定为“gpt-4o”。

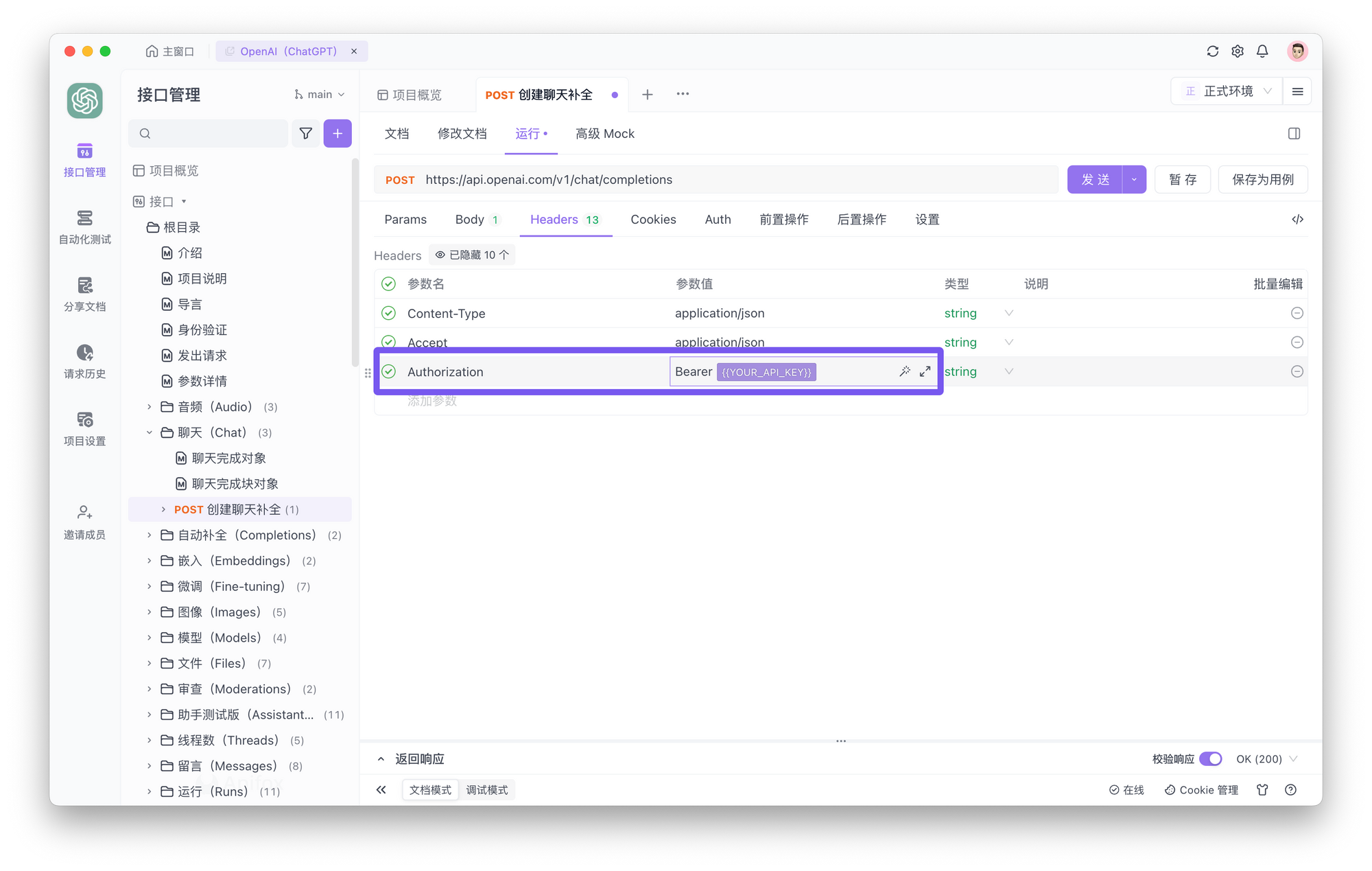

切换到“Headers”选项卡,添加授权参数以使用 ChatGPT API 进行身份验证,输入你获得的 ChatGPT API 密钥,然后单击“发送”按钮。

需要注意的是,在 Apifox 中,你可以将 OpenAI API 密钥存储为环境变量。将 OpenAI API 密钥存储为环境变量,以后就可以直接引用环境,无需重复重新输入,非常方便。

总结

在本文中,我们详细介绍了 OpenAI 的最新模型 GPT-4o。

- GPT-4o 的响应时间比之前的版本快一倍

- 可以理解文本、图像、音频和视频。

- 使用 Tokens 数量减少

- GPT-4o API 具有更高的智能

- 响应速度加快 2 倍

- 定价便宜 50%

- 速率限制提高 5 倍

- 改进的视觉功能

- 非英语语言处理能力提升

要使用 GPT-4o API,你需要创建 OpenAI 帐户并获取 API 密钥。使用 Apifox,你可以轻松测试和管理 GPT-4o API。 Apifox 有一个涵盖 GPT-4o API 规范的 OpenAI API 项目,你可以将 API 密钥存储为环境变量以避免重新输入。

将来,GPT-4o API 中将添加音频支持。通过利用 GPT-4o 的优秀功能并将其融入到你的服务中,你可以提供更好的 AI 体验。