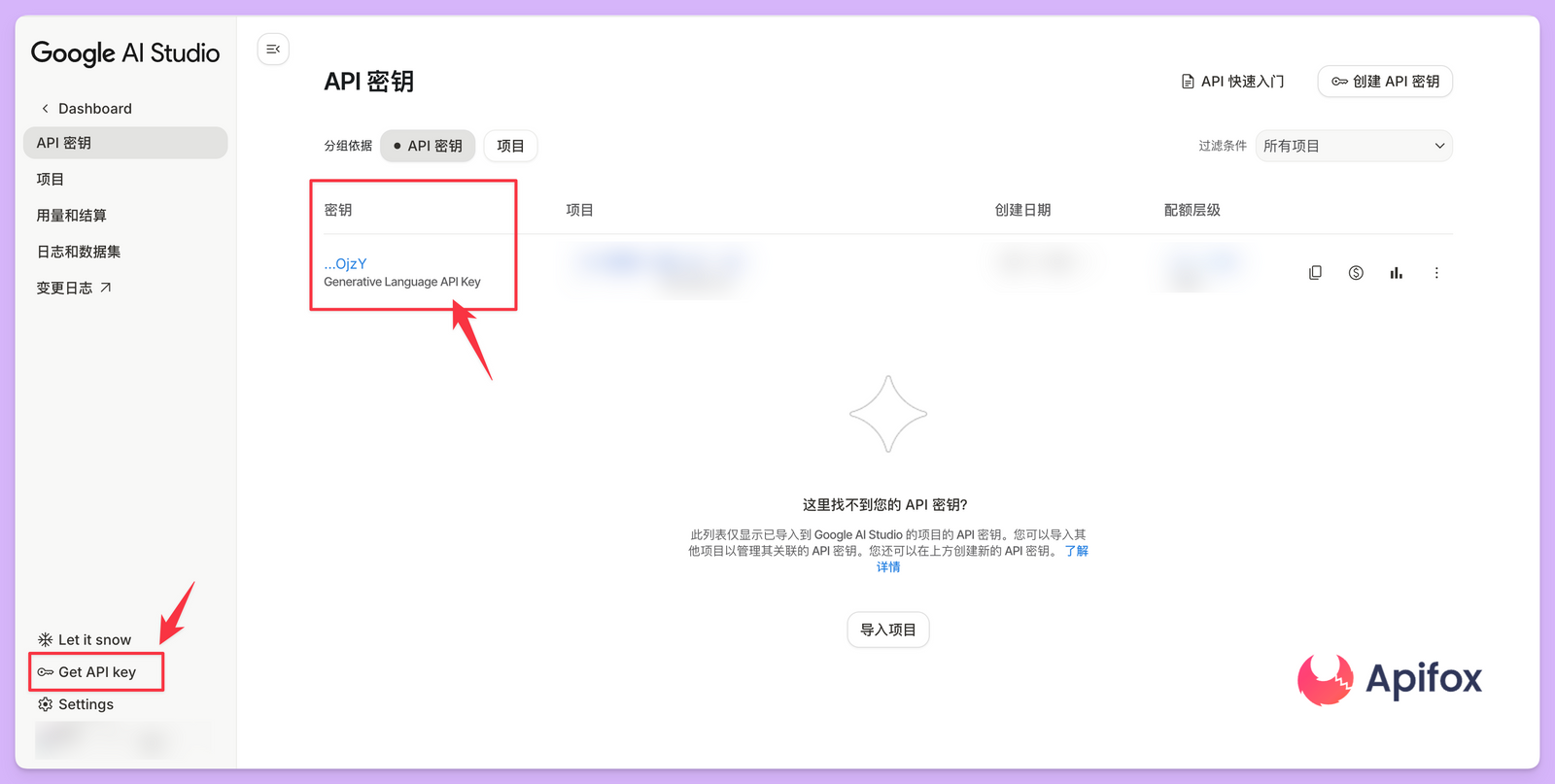

获取 Gemini API 密钥

调用谷歌 Gemini 3 Pro API 的第一步是获取身份验证凭据。所有的 API 密钥管理都在 Google AI Studio 中完成。访问 Google AI Studio 网站并登录后,侧边栏的 API Keys 选项卡提供了创建和管理密钥的入口。如果是初次使用,系统通常会引导创建一个默认的 Google Cloud 项目。

API 密钥本质上是与特定的 Google Cloud 项目绑定的。如果已经拥有现有的项目,可以通过 Import Projects 对话框将其导入到 AI Studio 环境中。导入成功后,即可在 API Keys 页面点击 Create API key 按钮生成一串字符。这串字符需要妥善保管,因为它是访问模型的唯一凭证,泄露可能导致配额被盗用。

密钥的安全配置与环境变量

为了避免将密钥直接硬编码在代码中,最推荐的做法是将其设置为系统环境变量。在不同的操作系统下,设置方法略有差异。

对于 Linux 或 macOS 用户,可以在 shell 配置文件如 .bashrc 或 .zshrc 中添加导出命令。

export GEMINI_API_KEY=YOUR_ACTUAL_API_KEY

添加完成后,运行 source ~/.zshrc 命令使配置立即生效。

Windows 用户则需要通过系统属性中的环境变量对话框,新建一个名为 GEMINI_API_KEY 的变量,并将密钥填入变量值。完成这些设置后,官方的 SDK 会自动识别该环境变量,从而简化代码中的初始化逻辑。

准备开发环境与安装 SDK

目前谷歌提供了多种语言的官方 SDK,包括 Python、JavaScript、Go 和 Java。对于大多数开发者来说,Python SDK 是最简单且功能覆盖最全的选择。安装过程非常直接,只需要使用包管理器执行安装指令即可。

pip install -U google-genai

如果是 JavaScript 开发者,则可以使用 npm 进行安装。安装完成后,就可以在项目中引入相应的模块进行接口调用。

npm install @google/genai

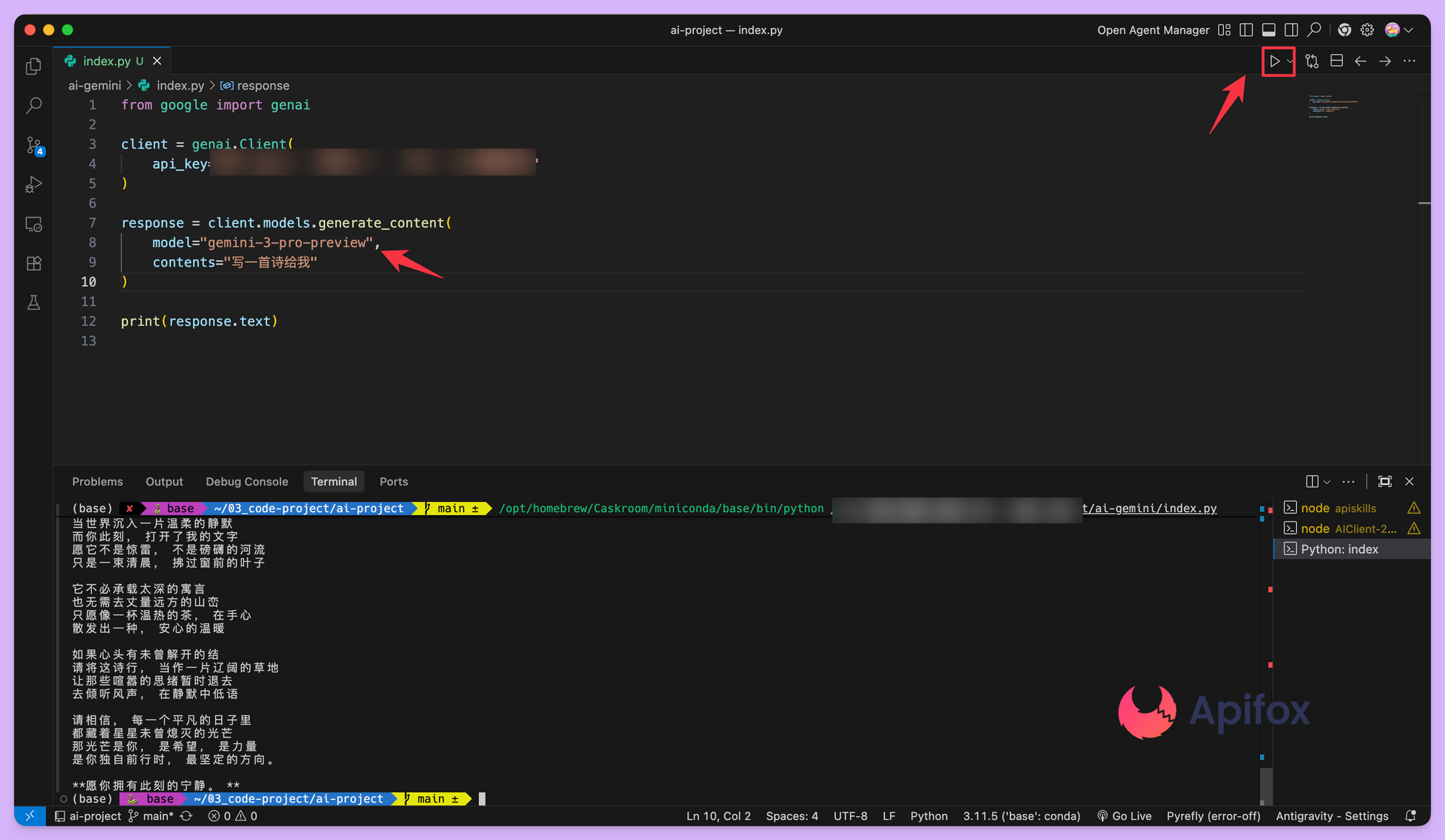

发起第一个 Gemini 3 Pro 文本调用

Gemini 3 Pro 是该系列中智能程度最高的模型,擅长处理复杂的逻辑推理。在代码中调用它时,需要指定正确的模型 ID,即 gemini-3-pro-preview。即便已经设置了环境变量,代码中依然需要实例化一个 Client 对象。

from google import genai

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="写一首诗给我"

)

print(response.text)

这段代码利用了 SDK 的自动发现机制,它会寻找名为 GEMINI_API_KEY 的环境变量。获取到的 response.text 属性包含了模型生成的最终文本。在 Gemini 3 系列中,由于模型具备原生推理能力,响应过程中可能会包含内部的思考路径。

如果你不想读取环境变量,而是在代码里直接传入 API Key,做法其实很简单:在实例化 Client 的时候,显式传入 apiKey 即可,跳过 SDK 的自动发现机制。

from google import genai

client = genai.Client(

api_key="YOUR_GEMINI_API_KEY"

)

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="写一首诗给我"

)

print(response.text)

你的 API Key 要充钱才能调用成功,免费额度很少,不知道能不能用,不能用的话用其他模式试试。

核心参数与能力对比

Gemini 3 系列不仅包含 Pro 版本,还有主打速度的 Flash 版本以及专门用于图像生成的 Image 版本。开发者在选择模型时,需要根据具体的业务场景、上下文窗口需求以及价格预算进行权衡。

Gemini 3 系列模型关键参数表

| 模型 ID | 输入上下文限制 | 输出限制 | 知识截止日期 | 主要能力特征 |

|---|---|---|---|---|

gemini-3-pro-preview |

1,048,576 tokens | 65,536 tokens | 2025年1月 | 最强推理、多步 Agent 任务、复杂编码 |

gemini-3-flash-preview |

1,048,576 tokens | 65,536 tokens | 2025年1月 | 高速度、低成本、Pro 级别智能、适合聊天 |

gemini-3-pro-image-preview |

65,536 tokens | 32,768 tokens | 2025年1月 | 4K 高质量图像生成、文字渲染、对话式编辑 |

控制模型的推理深度

Gemini 3 系列引入了一个全新的参数 thinking_level(推理等级)。与之前的版本不同,Gemini 3 会根据提示词的难度动态调整其内部的推理过程。通过这个参数,开发者可以手动干预模型是快速给出答案,还是进行更深层次的思考。

如果追求极低的延迟且任务相对简单,可以将 thinking_level 设置为 low。而在处理复杂的数学证明、逻辑悖论或大规模代码分析时,默认的 high 设置(即动态模式)能让模型表现出更强的思维深度。

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-preview",

contents="分析这道复杂的算法题:[代码题目]",

config=types.GenerateContentConfig(

thinking_config=types.ThinkingConfig(thinking_level="high")

),

)

print(response.text)

需要注意的是,Gemini 3 Flash 还额外支持 minimal 和 medium 等级。minimal 几乎等同于关闭推理过程,非常适合对响应时间极其敏感的即时聊天应用。

多模态输入与分辨率控制

Gemini 3 系列是原生的多模态模型,支持文本、图像、视频、音频以及 PDF 文件的混合输入。针对视觉输入,API 提供了 media_resolution 参数。这个参数决定了系统在处理媒体文件时分配的 token 数量,直接影响识别精度和成本。

媒体分辨率推荐设置表

| 媒体类型 | 推荐设置 | 单帧/单页 Token 使用 | 适用场景说明 |

|---|---|---|---|

| 图像 (Image) | media_resolution_high |

1120 | 需要识别精细文字或微小细节 |

| PDF 文档 | media_resolution_medium |

560 | 标准文档理解与 OCR 识别 |

| 普通视频 | media_resolution_low |

70 (每帧) | 动作识别、场景描述 |

| 文本密集型视频 | media_resolution_high |

280 (每帧) | 视频中的文字提取或代码分析 |

通过在请求中显式指定分辨率,可以精细化控制调用成本。例如在处理包含密集代码的截图时,建议手动将该参数提升至 high 以确保模型能看清每一个分号。

维护对话逻辑与 Thought Signatures

Gemini 3 接口调用的一个高级特性是 thoughtSignature(思维签名)。这是模型内部推理过程的加密表示。在多轮对话或工具调用场景中,必须将这些签名原样传回给模型,否则模型的逻辑推理能力会大幅下降,甚至在某些严格模式下会导致 API 报错。

如果是使用官方 SDK 内置的聊天对象,思维签名的传递是自动完成的。但如果是通过 REST API 自行构建历史记录,就必须注意从响应中提取 thoughtSignature 字段,并在下一次请求的历史序列中将其包含在对应的 model 角色部分。这种设计确保了模型能“记得”它在上一轮对话中未公开表达的思考逻辑。

图像生成与对话式编辑

调用 gemini-3-pro-image-preview 模型时,可以实现极其精细的图像生成。由于该模型内置了 Google Search Grounding 能力,它可以先联网搜索实时数据(如今天东京的天气),然后再生成符合事实的图像。

from google import genai

from google.genai import types

client = genai.Client()

response = client.models.generate_content(

model="gemini-3-pro-image-preview",

contents="生成一张当前伦敦天气的可视化海报",

config=types.GenerateContentConfig(

tools=[{"google_search": {}}],

image_config=types.ImageConfig(

aspect_ratio="16:9",

image_size="4K"

)

)

)

for part in response.parts:

if part.inline_data:

image = part.as_image()

image.save('london_weather.png')

在图像编辑流程中,思维签名的重要性更加凸显。当提出修改建议(如“把背景改成日落”)时,模型需要依赖上一轮生成的思维签名来理解原始图像的构图和光影逻辑,从而实现连贯的局部修改。

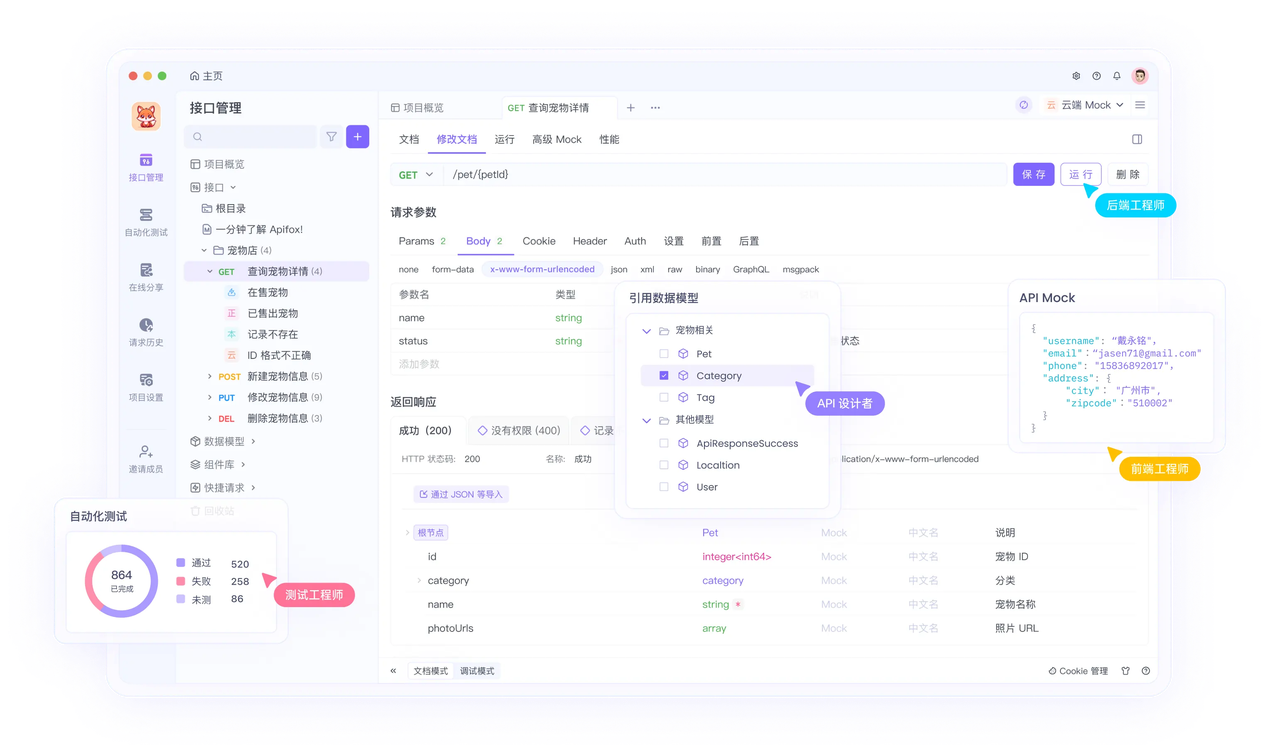

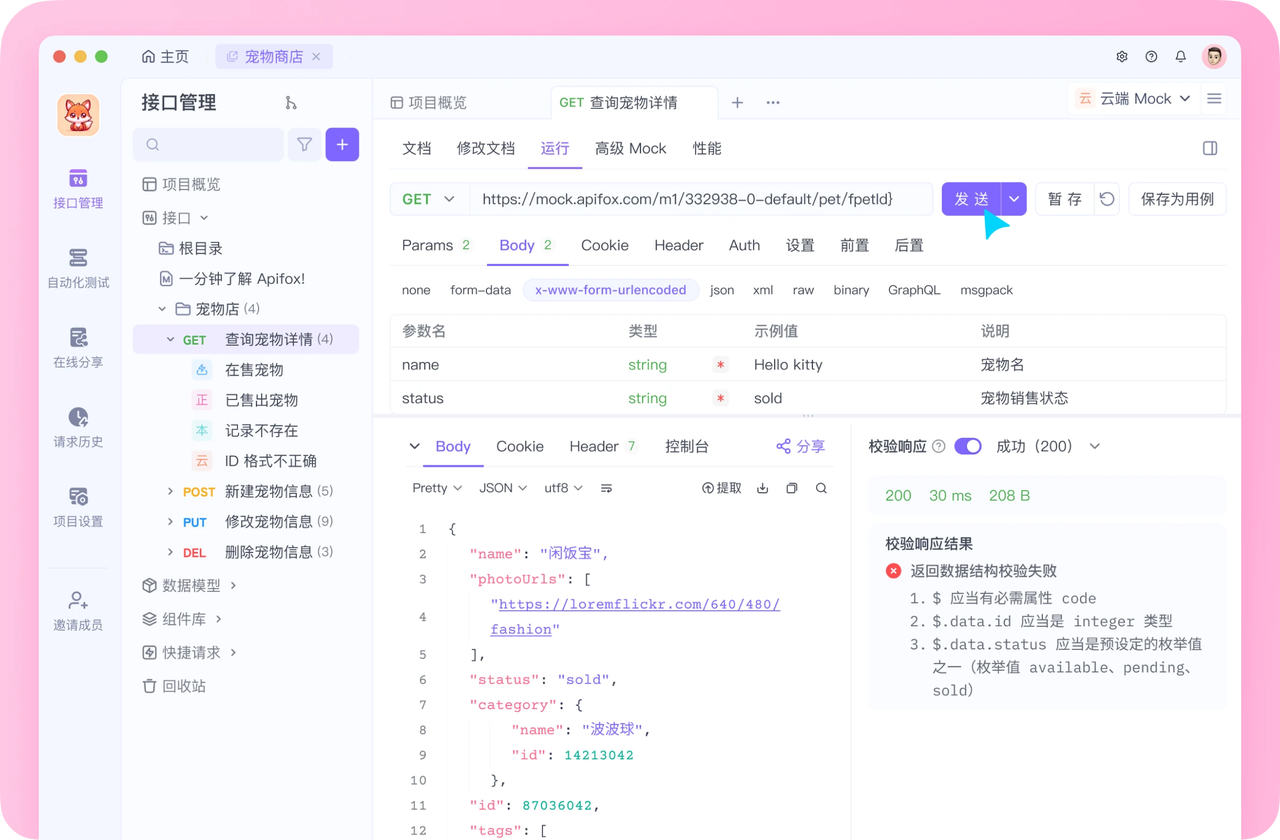

开发必备:API 全流程管理神器 Apifox

介绍完上文的内容,我想额外介绍一个对开发者同样重要的效率工具 —— Apifox。作为一个集 API 文档、API 调试、API 设计、API 测试、API Mock、自动化测试等功能于一体的 API 管理工具,Apifox 可以说是开发者提升效率的必备工具之一。

如果你正在开发项目需要进行接口调试,不妨试试 Apifox。注册过程非常简单,你可以直接在这里注册使用。

注册成功后可以先看看官方提供的示例项目,这些案例都是经过精心设计的,能帮助你快速了解 Apifox 的主要功能。

使用 Apifox 的一大优势是它完全兼容 Postman 和 Swagger 数据格式,如果你之前使用过这些工具,数据导入会非常方便。而且它的界面设计非常友好,即使是第一次接触的新手也能很快上手,快去试试吧!