开发人员不断寻求能够提高生产力且不增加成本的工具。GLM-4.5 的出现改变了这一领域的格局,为编码任务提供了强大的功能。将其与 Claude Code 搭配使用,您将获得可与顶级模型相媲美的高级 AI 辅助。

认识 GLM-4.5:高级 AI 编码的基础

GLM-4.5 是智谱 AI(Z.ai)推出的旗舰级大语言模型,专为智能代理类应用设计。智谱 AI 的工程师采用混合专家(Mixture-of-Experts,MoE)架构,在每次前向传播过程中,会从总计 3550 亿参数中激活 320 亿参数。这种设计在保证处理复杂任务能力的同时,优化了计算效率,避免了过高的资源消耗。

此外,GLM-4.5 经过 15 万亿个 token 的预训练,随后又在代码生成、推理和智能代理行为相关的专用数据集上进行微调。它支持 128K token 的上下文窗口,能一次性处理大规模代码库或多步骤指令,减少开发者重复输入提示的需求,这一特性深受开发者青睐。

GLM-4.5 还内置混合推理模式:针对复杂问题的「思考模式(Thinking Mode)」和用于快速响应的「非思考模式(Non-Thinking Mode)」。你可通过 API 调用中的thinking.type参数激活对应模式,根据任务需求灵活切换。

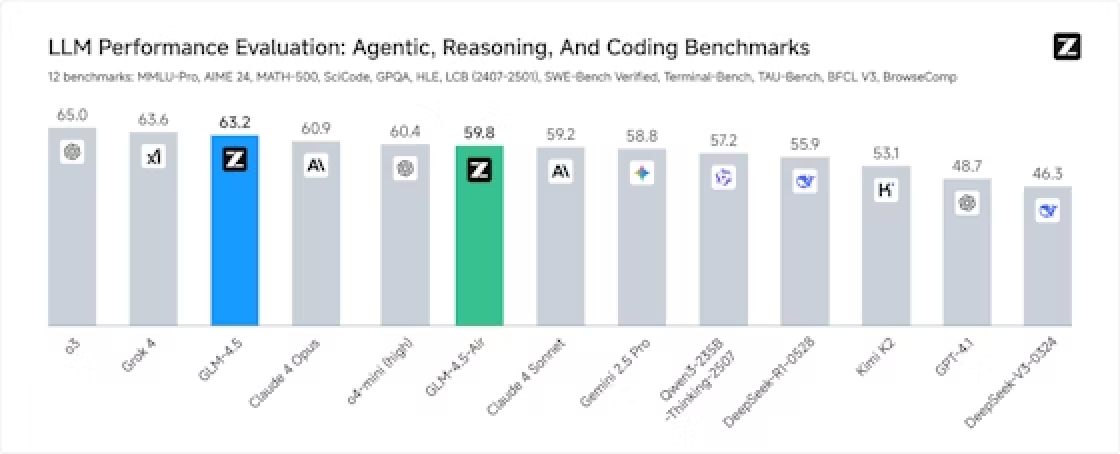

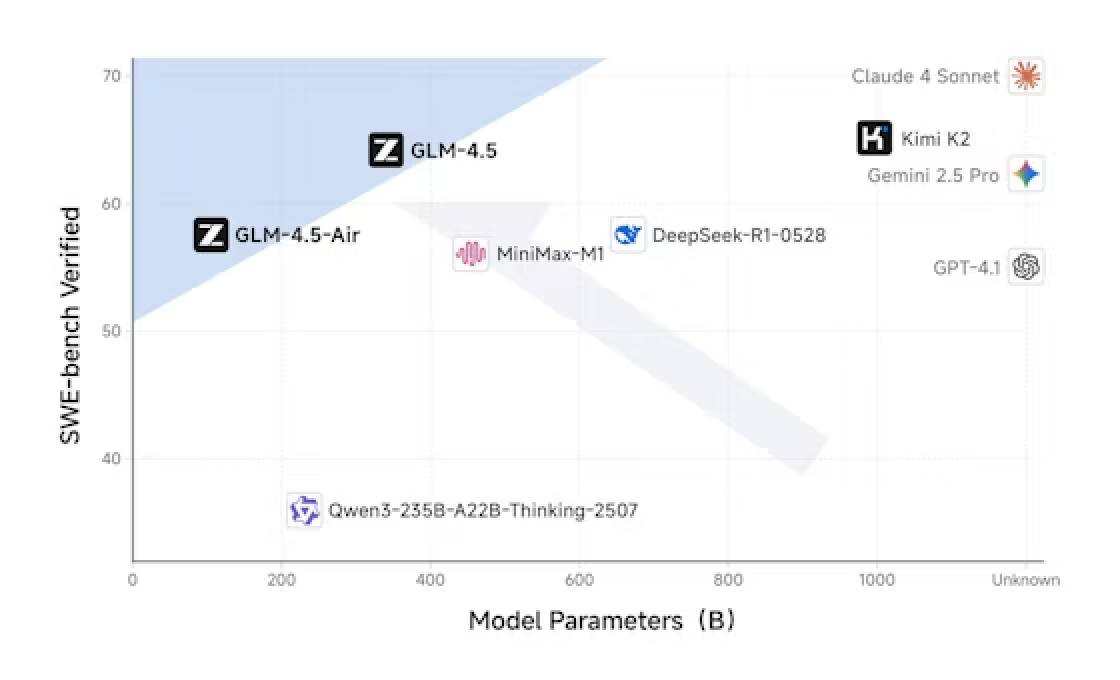

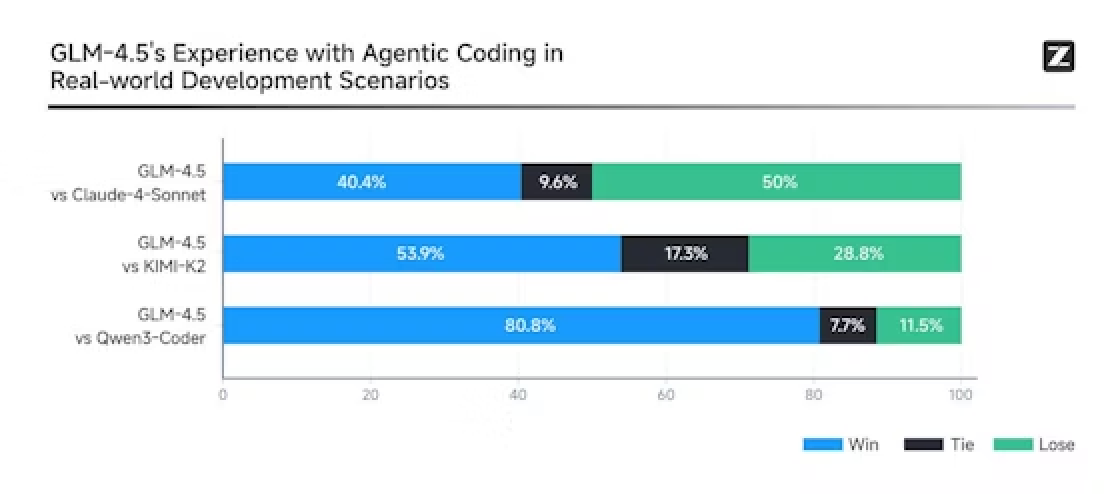

多项基准测试印证了 GLM-4.5 的实力:在涵盖多领域推理的 MMLU Pro、实时编码挑战的 LiveCodeBench 等 12 项测试套件中,它位列全球第二。实际应用中,GLM-4.5 生成 Python 脚本或 JavaScript 函数的准确率极高,在函数调用任务中常优于 Claude 3.5 Sonnet 等模型。而其真正的优势在于智能代理功能——能自主调用工具、浏览网页或设计软件组件。

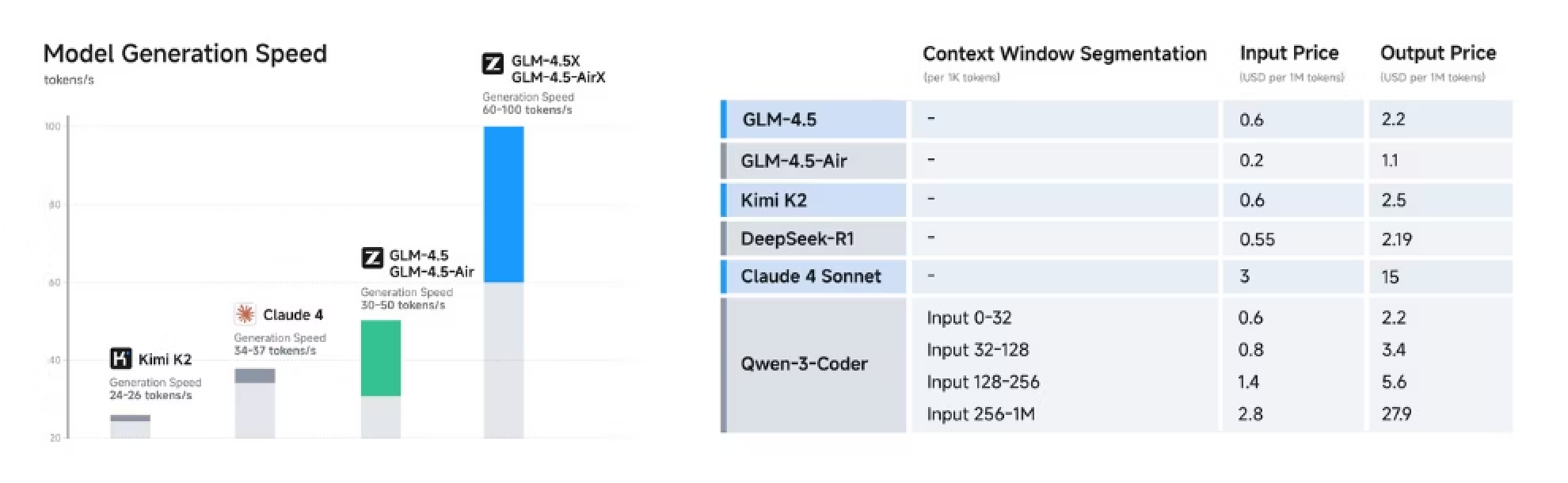

还有轻量级变体 GLM-4.5-Air,总参数 1060 亿,激活参数 120 亿,虽算力稍弱,但速度更快,适合对效率要求高于算力的场景。这两款模型均能与开发工具无缝集成,成为编码环境的理想搭档,帮助团队简化从遗留代码调试到新应用原型开发的全流程。

什么是 Claude Code?为何要与 GLM-4.5 集成?

Claude Code 是基于终端的编码助手,借助 AI 自动化开发任务。用户可将其作为 CLI 工具安装,或集成到 VS Code 等 IDE 中。Claude Code 最初基于 Anthropic 的 Claude 模型设计,能通过自然语言指令执行命令、生成代码片段、管理代码仓库。例如,你只需输入“重构这个函数以提升性能”,它就能返回优化后的代码。

GLM-4.5 与 Claude Code 的集成,依托智谱 AI 提供的兼容 Anthropic 的 API 端点实现。这种兼容性意味着,无需修改 Claude Code 的核心功能,就能将默认的 Claude 模型替换为 GLM-4.5。开发者可将请求路由到智谱 AI 的服务器,享受 GLM-4.5 更高的工具调用成功率——基准测试中成功率高达 90%。

为何要做此替换?一方面,GLM-4.5 在成本和智能代理编码性能上更具优势:重度使用下,传统 Claude 套餐月费可能达 100-200 美元,而智谱 AI 的 GLM 编码套餐起价仅 3 美元(Lite 版),Pro 版也仅 15 美元,能提供相当于 Claude 同级别套餐 3 倍的使用额度,对独立开发者和初创公司极具吸引力。另一方面,GLM-4.5 在前端开发、bug 修复等领域表现突出,原本需数小时手动完成的任务,它几分钟就能搞定。

结合 GLM-4.5 与 Claude Code 的优势

将 GLM-4.5 与 Claude Code 结合,能带来切实可见的好处:

1. 迭代周期更快

GLM-4.5 的生成速度超过每秒 100 token ,能在 Claude Code 中提供实时代码建议。这种快速响应在调试场景中至关重要——及时的修复方案可避免开发流程中断。

2. 编码准确率更高

GLM-4.5 经过强化学习微调,输出更可靠,减少代码生成不存在或错误的代码。例如,在 Java 或 C++等语言的编码中,它会自动遵循最佳实践,加入错误处理和优化逻辑,让开发者减少修改 AI 生成代码的时间。

3. 成本效率更优

15 美元/月的 GLM 编码 Pro 版,能解锁高强度任务,使用额度是 Claude Max 套餐的 3 倍;3 美元/月的 Lite 版则适合轻量需求,让高级 AI 能力触手可及。这两个套餐均基于 GLM-4.5 和 GLM-4.5-Air 构建,且未来还将支持更多工具集成,进一步扩展功能。

4. 安全性更强

智谱 AI 的 API 支持 JSON 等结构化输出,确保 Claude Code 中响应的可预测性;同时,上下文缓存功能减少冗余计算,降低长会话中的延迟。

5. 可定制性更高

GLM-4.5 的开源特性允许自定义调整:团队可针对特定领域任务微调模型,使其更深度地融入 Claude Code 工作流。总体而言,这一组合将编码从单人操作转变为 AI 辅助的高效协作过程。

在 Claude Code 中配置 GLM-4.5

如何在 Claude Code 中配置 GLM-4.5,其实很简单:

步骤 1:准备环境

- 通过官方 CLI 或扩展程序安装 Claude Code

- 访问智谱 AI(Z.ai)平台注册账号,获取 API 密钥

- 若使用量超过免费额度,订阅 GLM 编码套餐——Lite 版适合新手,满足基础需求

步骤 2:配置集成参数

- 在 Claude Code 的设置中,找到 API 配置文件(通常路径为

~/.claude/config.yaml) - 将基础 URL 更新为智谱 AI 的端点:

https://api.z.ai/api/paas/v4/chat/completions - 在授权请求头中填入你的 API 密钥

步骤 3:测试配置是否生效

- 启动 Claude Code,输入简单指令:“生成一个排序列表的 Python 函数”

- GLM-4.5 会通过兼容 API 处理请求并返回代码,需验证输出的正确性

步骤 4:启用高级功能

- 处理复杂任务时,将

thinking.type设置为“enabled”,激活 GLM-4.5 的深度推理能力,适合架构设计等场景 - 在请求中添加

stream: true启用流式传输,实现 Claude Code 中代码的渐进式显示

步骤 5:工具调用设置

GLM-4.5 支持函数调用:在提示中定义工具(如网页浏览工具),模型会自动调用;Claude Code 会无缝路由这些工具请求。

步骤 6:问题排查

- 若认证失败,重新生成 API 密钥;

- 若遇到速率限制,在智谱 AI 控制台监控使用情况;

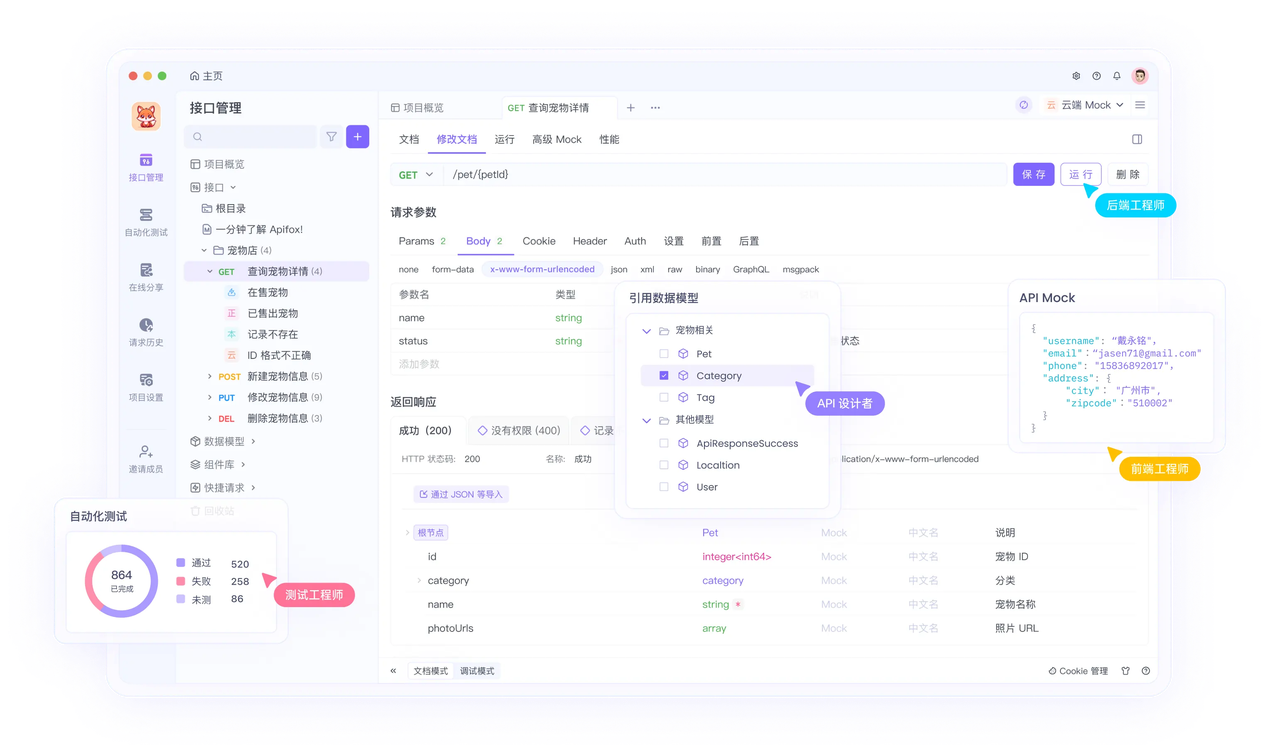

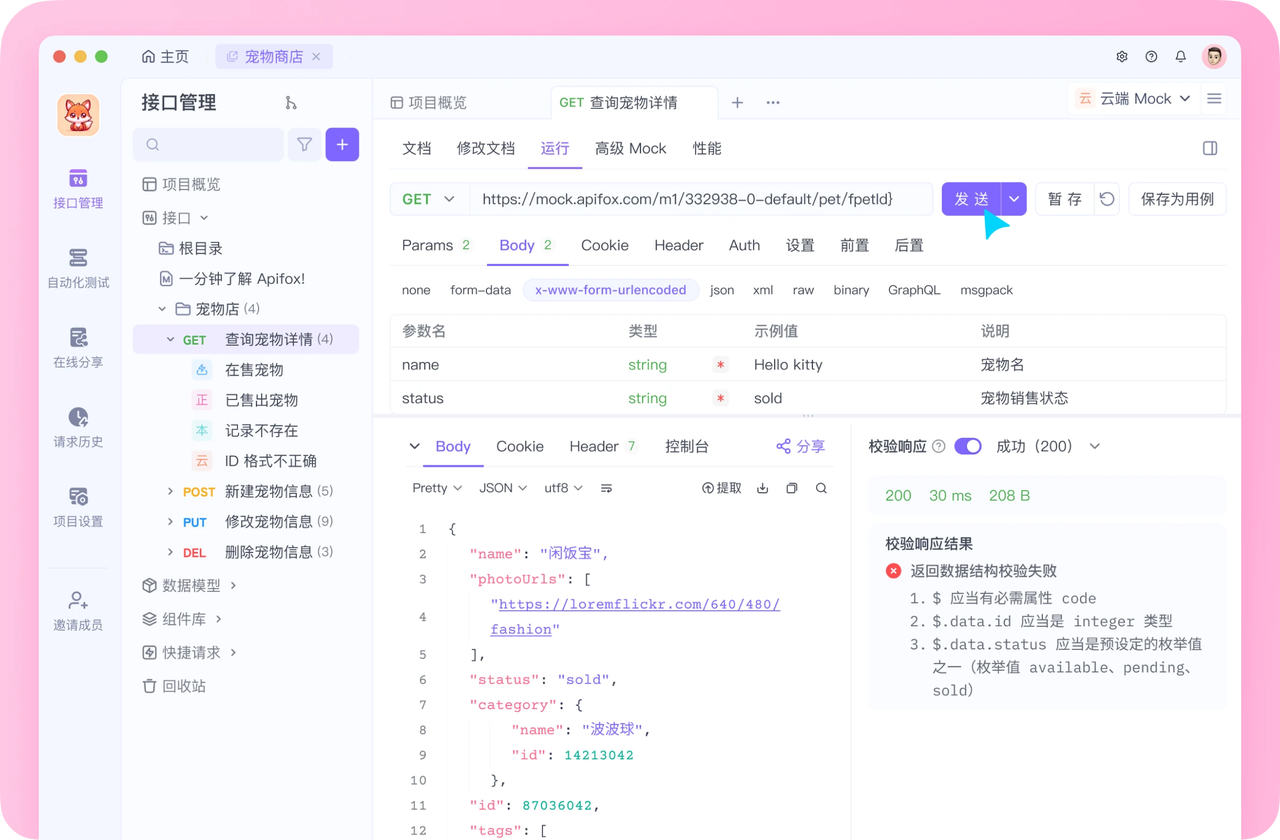

- 可借助 Apifox 在实际集成前模拟 API 调用,提前排查问题。

用 Apifox 测试 GLM-4.5 API

Apifox 能简化 API 测试流程,是 GLM-4.5 与 Claude Code 集成的关键辅助工具,具体操作如下:

- 创建项目与导入规范:在 Apifox 中新建项目,导入智谱 AI 的 OpenAPI 规范,定义

/chat/completions等接口; - 构建请求:设置请求头(包含 API 密钥和

content-type: application/json),在请求体中指定模型为“glm-4.5”,并添加包含提示的messages数组; - 执行测试:Apifox 发起调用后,会显示响应内容及状态码,可验证输出是否符合预期(如代码是否为 JSON 结构化格式);

- 自动化测试场景:创建测试套件,覆盖不同场景——例如对比“思考模式”与“非思考模式”的效果,或测试不同温度参数(如 0.6,平衡创造性与稳定性)的输出差异;

- 性能监控:Apifox 追踪请求延迟和错误率,帮助在 Claude Code 部署前优化参数;

- CI/CD 集成:将 Apifox 脚本导出到流水线,确保 GLM-4.5 在更新后仍保持可靠。

在 Claude Code 中发挥 GLM-4.5 的智能代理

功能GLM-4.5 在智能代理任务中表现突出:

- 定义专属代理:在 Claude Code 的提示中定义代理角色,由 GLM-4.5 协调执行。例如,创建“重构代理”,输入指令“分析这个代码库并提出改进建议”

- 多工具链式调用:GLM-4.5 能处理工具链任务——浏览文档、生成代码、执行测试,全流程在一个会话中完成

- 定制化微调:向智谱 AI 上传专属数据集,训练自定义模型,再将 Claude Code 的请求路由到该模型

- 缓存优化扩展:将上下文存储到 GLM-4.5 的缓存中,加速迭代式编码

- 模型变体灵活切换:简单任务用 GLM-4.5-Air 提升速度,复杂任务切换回完整版 GLM-4.5

定价与套餐

智谱 AI 为 Claude Code 用户定制了专属套餐:

- Lite 版(3 美元/月):适合偶尔编码需求,提供相当于 Claude Pro 套餐 3 倍的使用额度;

- Pro 版(15 美元/月):适合专业开发者,使用额度是 Claude Max 套餐的 3 倍;

- 免费额度:供测试使用,而付费套餐能解锁无限制功能。

对比来看,标准 API 按“每百万输入 token 0.2 美元”计费,而套餐形式能大幅降低成本,性价比更高。

总结

将 GLM-4.5 与 Claude Code 集成,能为开发者赋能。遵循本文步骤,借助 Apifox 的辅助,进一步打通“API 测试-文档-协作”全环节,让整个开发链路更顺畅、更可靠,彻底改变你的编码方式。这一组合兼具效率、准确率与性价比,不妨从现在开始尝试。