开发者需要平衡性能、成本与速度的 AI 模型,而 Claude Haiku 4.5 正是目前首选,能为各类应用提供高级能力支持。今天我们会详细讲解工程师与程序员如何在项目中部署 Claude Haiku 4.5 API,从初始搭建到复杂集成,助力大家充分挖掘其潜力。

本指南将以循序渐进的方式展开:先带你理解 Claude Haiku 4.5 的核心属性,再逐步推进到实际部署环节。

Claude Haiku 4.5 核心特性

Anthropic 设计的 Claude Haiku 4.5 是一款“小而精”的模型,主打速度与效率。它受青睐的关键原因是:能提供接近前沿模型的性能,却无需承担大型模型的资源开销。

具体而言,Claude Haiku 4.5 的编码能力堪比 Claude Sonnet 4,但成本仅为前者的三分之一,速度却提升两倍以上。得益于优化后的算法,在降低计算需求的同时,保持了高准确率。

相较于前代产品 Claude Haiku 3.5,该版本在安全性评估中表现更优:

- 对齐能力增强,异常行为发生率显著降低,成为生产环境的更安全选择

- 属于 AI 安全等级 2(ASL-2),在化学、生物、辐射、核(CBRN)等应用场景中的风险极低,相比 Claude Sonnet 4.5(ASL-3),部署范围更广泛

- 核心能力包括低延迟实时处理,适用于聊天助手、客服机器人、结对编程等场景

- 在编码任务中,它能拆解复杂问题、提出优化建议、实时调试代码

- 还支持多智能体系统,由 Claude Sonnet 4.5 等协调模型将任务拆分给多个 Claude Haiku 4.5 实例并行执行,加速软件原型开发、数据分析及交互式应用的工作流

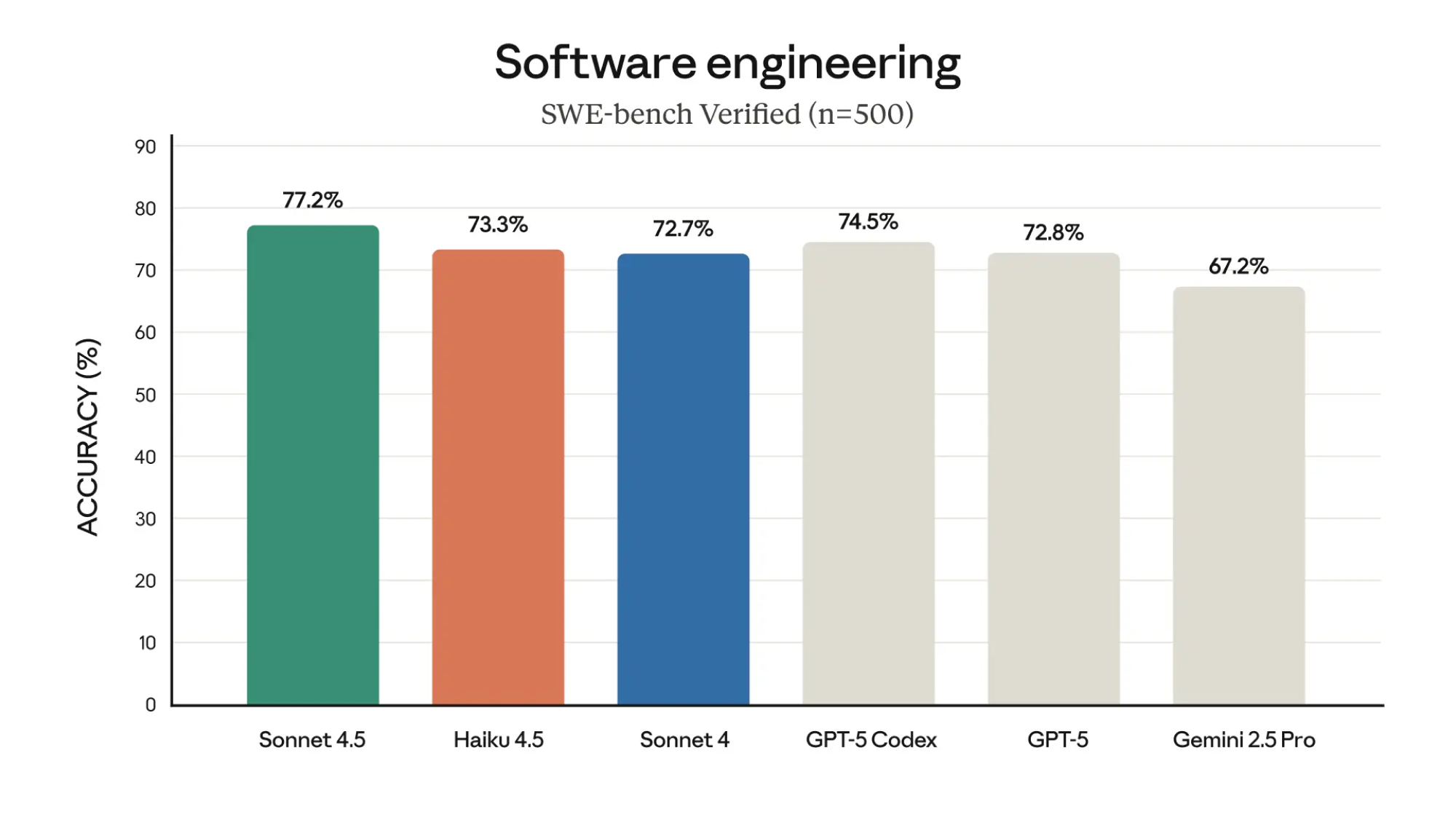

基准测试表现

在 SWE-bench Verified 基准测试中(基于 500 个任务,Docker 环境,128K Token 思考预算),Claude Haiku 4.5 平均得分 73.3%。测试中它借助 bash 和文件编辑工具搭建简易框架,工具调用频率极高(单任务常超 100 次),在调试与功能实现上的表现优于 OpenAI 的 GPT-5 等竞品。其他测试中,Terminal-Bench(无思考预算时平均 40.21%,32K 预算时 41.75%)和 OSWorld(四次运行,最大 100 步)的结果,也印证了它在智能体交互与操作系统交互中的可靠性。

测试场景 | Claude Sonnet 4.5 | Claude Haiku 4.5 | Claude Sonnet 4 | GPT-5 | Gemini 2.5 Pro |

|---|---|---|---|---|---|

智能体编码(SWE-bench Verified) | 77.2% | 73.3% | 72.7% | 72.8%(GPT-5 高)、74.5%(GPT-5-Codex) | 67.2% |

智能体终端编码(Terminal-Bench) | 50.0% | 41.0% | 36.4% | 43.8% | 25.3% |

计算机使用(OSWorld) | 61.4% | 50.7% | 42.2% | - | - |

高中数学竞赛(AIME 2025) | 100%(Python)、87.0%(无工具) | 96.3%(Python)、80.7%(无工具) | 70.5% | 99.6%(Python)、94.6%(无工具) | 88.0% |

研究生级推理(GPQA Diamond) | 83.4% | 73.0% | 76.1% | 85.7% | 86.4% |

多语言问答(MMMLU) | 89.1% | 83.0% | 86.5% | 89.4% | - |

视觉推理(MMMU 验证集) | 77.8% | 73.2% | 74.4% | 84.2% | 82.0% |

此外,Claude Haiku 4.5 能与 Amazon Bedrock、Google Cloud Vertex AI 等平台无缝集成,开发者可直接替换 Haiku 3.5 或 Sonnet 4 等旧模型,同时享受更经济的定价。在推进搭建流程前,建议结合项目需求评估这些特性的适配性。

Claude Haiku 4.5 API 的定价详情

成本效率是采用任何 AI 模型的关键考量。Anthropic 为 Claude Haiku 4.5 定价为:$1/每百万输入 token,$5/每百万输出 token。这价格使其成为 Claude 系列中最实惠的选项,支持高吞吐量使用而无需承担过高成本。作为对比,Claude Haiku 3.5 的定价为每百万输入 Token 0.8 美元、每百万输出 Token 1.6 美元,但新版本在性能提升的同时,仍保持了极具竞争力的价格。

-Claude 系列模型定价对比

模型 | 输入定价(每百万 Token) | 输出定价(每百万 Token) | 提示缓存(写/每百万 Token) | 提示缓存(读/每百万 Token) |

|---|---|---|---|---|

Opus 4.1 | 15 美元 | 75 美元 | 18.75 美元 | 1.50 美元 |

Sonnet 4.5( ≤200K Token) | 3 美元 | 6 美元 | 3.75 美元 | 0.30 美元 |

Sonnet 4.5( >200K Token) | 0.10 美元 | 0.20 美元 | 7.50 美元 | 0.60 美元 |

Haiku 4.5 | 1 美元 | 5 美元 | 1.25 美元 | 0.10 美元 |

额外的提示缓存功能定价为:每百万写 Token 1.25 美元,每百万读 Token 0.10 美元,适用于应用中的重复查询优化。通过 Amazon Bedrock、Google Vertex AI 等第三方平台访问该模型时,定价可能因平台手续费略有差异,但基础费率保持一致。

对规模化集成 AI 的企业而言,这一定价对原型开发和生产部署均很友好。例如,每日处理数千次交互的客服机器人,较低的输入成本能显著降低运营开支。但需密切监控 Token 使用情况,复杂任务若配置了大量思考预算,可能导致费用累积。Apifox 等工具可在测试阶段模拟请求并估算成本,助力预算管控。

了解定价后,接下来聚焦如何获取访问权限并配置 Claude Haiku 4.5 API 的使用环境。

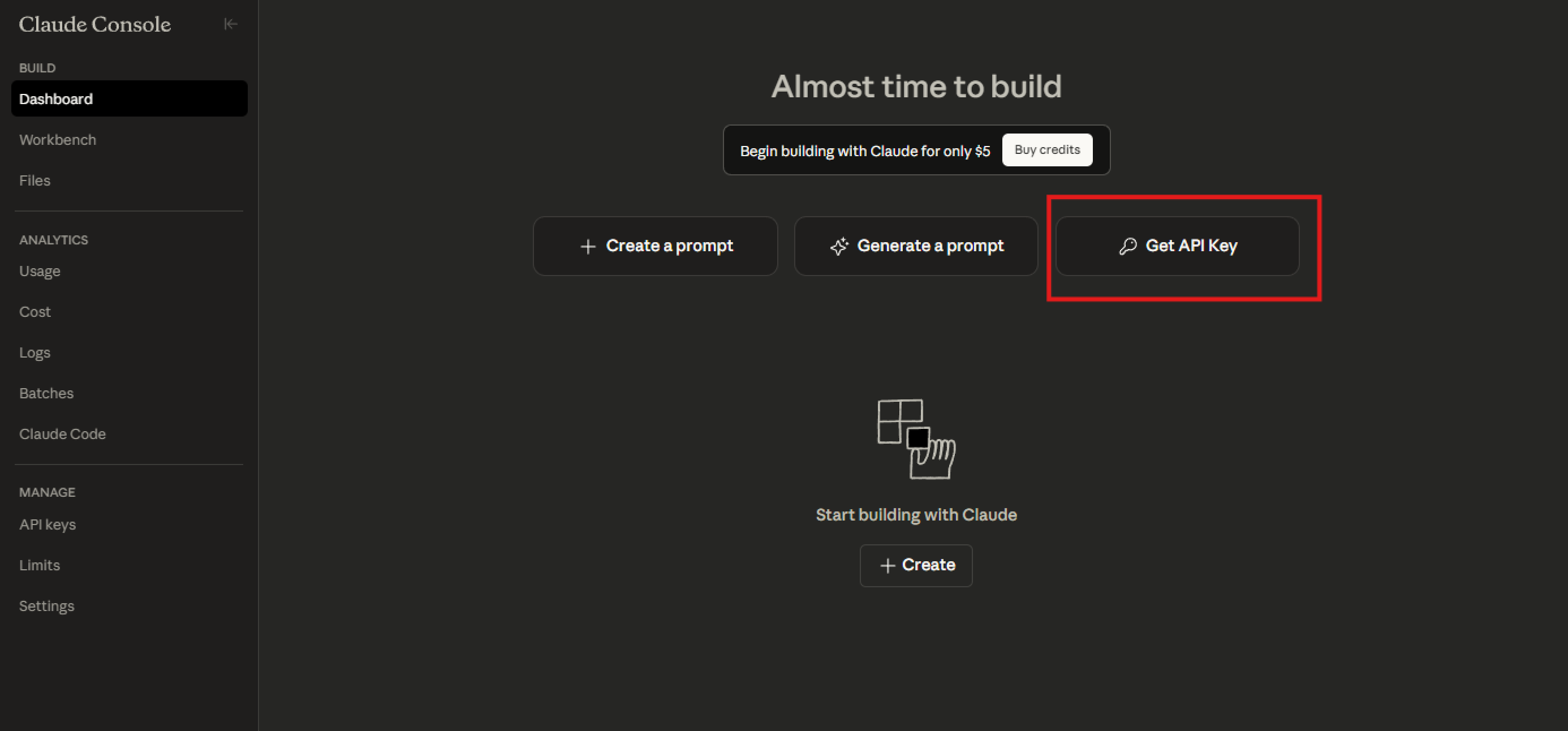

搭建 Claude Haiku 4.5 API 的访问环境

要开始使用 Claude Haiku 4.5,需先从 Anthropic 获取 API 密钥:

- 访问 Anthropic 开发者控制台,若未注册需先创建账户

- 登录后在 API 板块生成新密钥,务必安全存储, 它将用于所有请求的身份验证

环境配置步骤

1. 安装依赖库

Python 开发者可使用官方 Anthropic SDK,在终端执行以下命令安装:

pip install anthropic 2. 配置 API 密钥

将 API 密钥设为环境变量(推荐生产环境使用):

export ANTHROPIC_API_KEY='your-api-key-here' 3. 第三方平台访问(可选):

- Amazon Bedrock 用户:登录 AWS 控制台,启用 Anthropic 模型,选择 Claude Haiku 4.5,Bedrock 提供托管服务,无需管理底层基础设施

- Google Vertex AI 用户:通过 Model Garden 访问模型,选择 Claude Haiku 4.5 后,通过 REST API 或 SDK 集成

4. 验证环境搭建

用简单的测试请求确认配置成功,Python 示例代码如下:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=1000,

temperature=0.7,

messages=[

{"role": "user", "content": "Hello, Claude Haiku 4.5!"}

]

)

print(message.content) Apifox 可进一步优化搭建流程:导入 Claude API 的 OpenAPI 规范,创建新项目并添加 Anthropic 端点,即可生成 Mock 响应支持离线开发,确保集成工作顺畅推进。环境配置完成后,继续探索基础 API 调用及参数设置。

Claude Haiku 4.5 API 的基础使用

Claude Haiku 4.5 API 的核心是“消息端点(messages endpoint)”,用于处理对话交互。开发者需构造包含“消息列表”的请求,每条消息需指定角色(用户或助手)和内容,模型将基于上下文生成回复。

关键参数说明

max_tokens:限制响应长度,避免生成内容过多temperature:控制随机性(取值 0-1),低数值(如 0.2)适合技术任务,输出更具确定性top_p:通过采样概率质量影响结果多样性

编码任务示例(Python)

查询模型生成递归计算斐波那契数列的 Python 函数:

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=500,

messages=[

{"role": "user", "content": "编写一个递归计算斐波那契数列的Python函数。"}

]

)

print(message.content[0].text) 响应会包含函数代码及相关解释,Claude Haiku 4.5 的高速度能支持快速迭代,特别适合调试场景。

错误处理:带重试机制的请求函数

针对速率限制、参数无效等常见问题,实现带指数退避的重试逻辑:

import time

def send_message_with_retry(client, params, max_retries=3):

for attempt in range(max_retries):

try:

return client.messages.create(**params)

except anthropic.APIError as e:

if attempt < max_retries - 1:

time.sleep(2 ** attempt) # 重试间隔:1s→2s→4s

else:

raise e 该函数能提升生产环境中的请求可靠性。

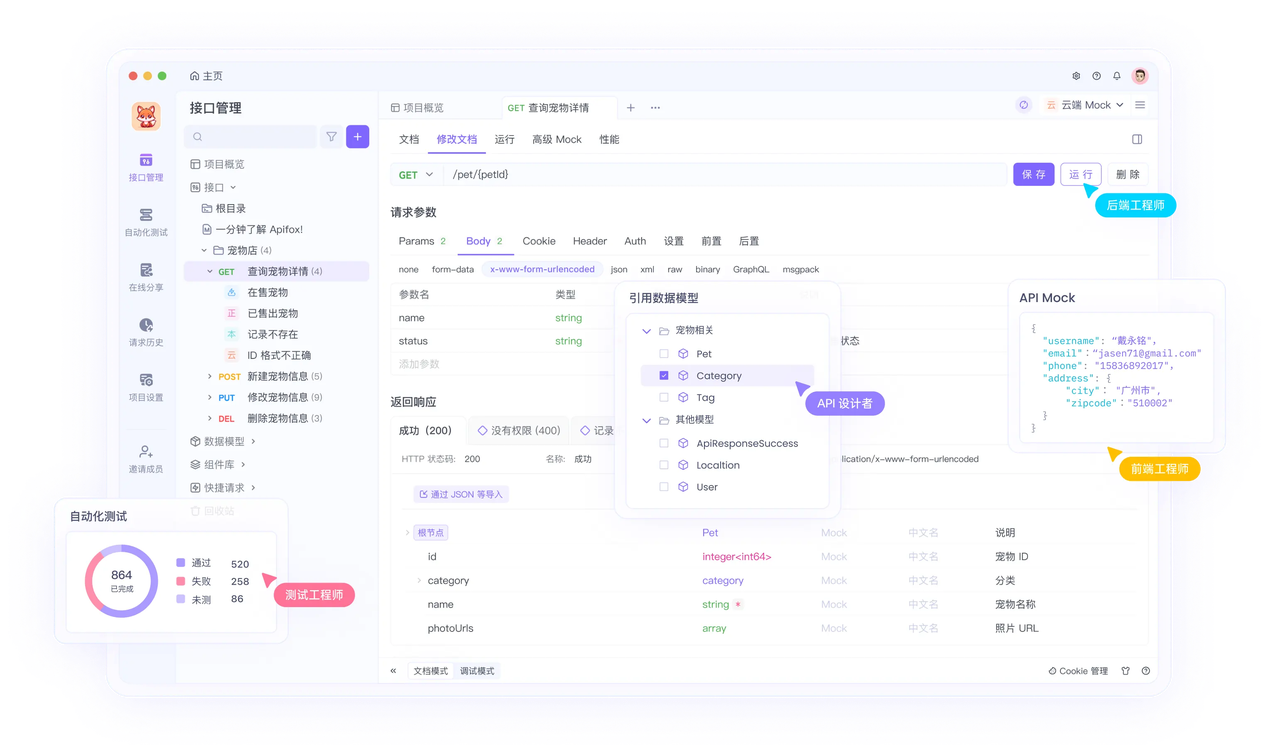

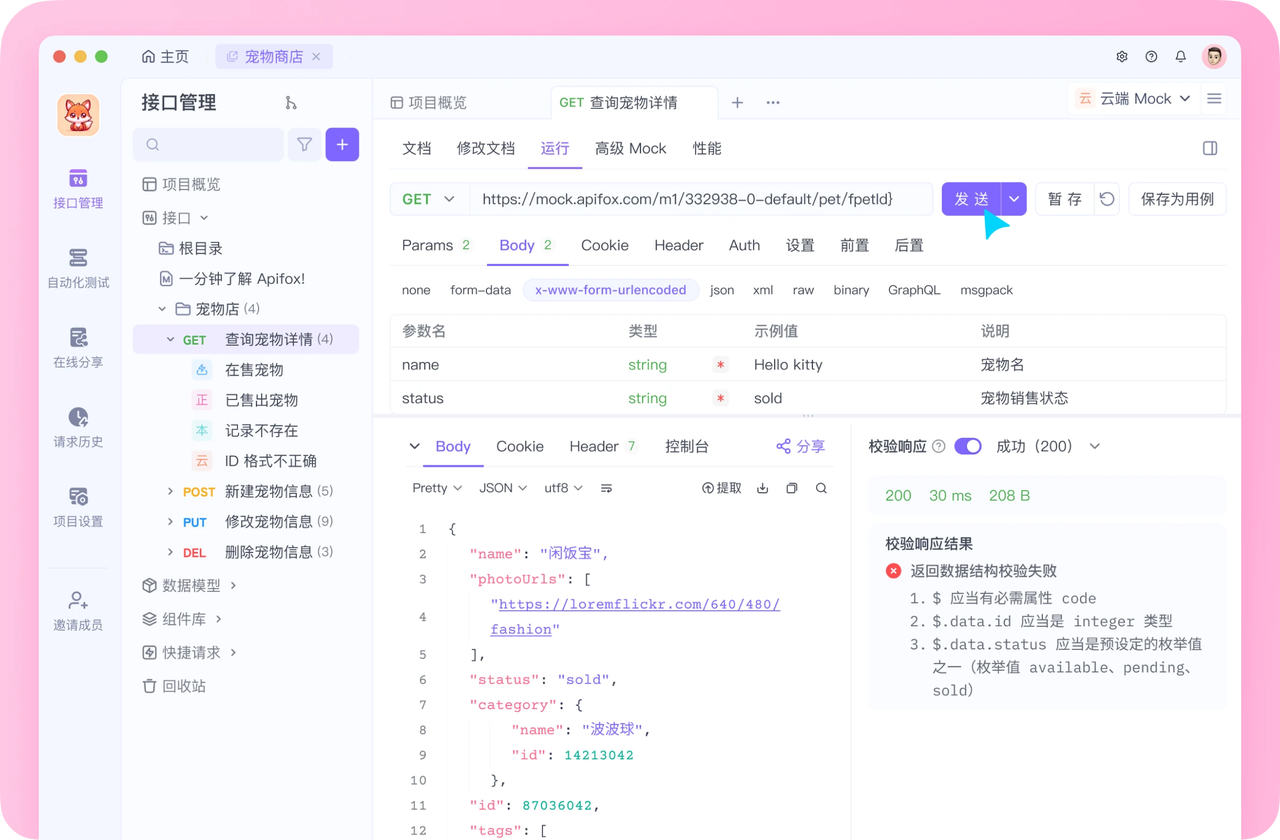

用 Apifox 测试基础调用

在 Apifox 中创建新 API 请求,配置如下:

- URL:

https://api.anthropic.com/v1/messages - 请求头:添加

x-api-key,值为你的 API 密钥 - 请求体:按 JSON 格式定义模型、参数及消息内容

发送请求后,Apifox 会格式化显示响应结果,便于分析调试。

掌握基础交互后,可进阶探索工具集成与多智能体系统等复杂场景。

工具集成与多智能体系统

Claude Haiku 4.5 支持工具调用功能,能与外部函数交互。只需在请求中定义工具,模型会自主判断何时调用。例如,创建一个用于数学计算的工具:

工具调用示例(Python)

tools = [

{

"name": "calculator",

"description": "执行算术运算",

"input_schema": {

"type": "object",

"properties": {

"expression": {"type": "string"} # 需计算的表达式

},

"required": ["expression"]

}

}

]

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=1000,

tools=tools,

messages=[

{"role": "user", "content": "15乘以23等于多少?"}

]

) 若模型调用工具,需处理其输入并在后续消息中返回计算结果,从而拓展模型的能力边界(超越纯文本生成)。

多智能体系统实现

在多智能体架构中,可由 Claude Sonnet 4.5 负责任务规划,Claude Haiku 4.5 负责执行。协调模型将复杂任务拆分为子任务,分配给多个 Haiku 实例并行处理,例如软件开发中,一个智能体负责数据获取,另一个负责 UI 设计。

异步并行执行示例(Python)

import asyncio

async def execute_subtask(client, subtask):

# 异步调用Claude Haiku 4.5处理子任务

return await asyncio.to_thread(

client.messages.create,

model="claude-haiku-4-5",

max_tokens=500,

messages=[{"role": "user", "content": subtask}]

)

async def main():

subtasks = ["获取用户数据", "设计登录页面"]

# 并发执行所有子任务

results = await asyncio.gather(*(execute_subtask(client, task) for task in subtasks))

# 聚合结果并后续处理

print("子任务结果:", [res.content[0].text for res in results])

# 运行主函数

asyncio.run(main()) 该代码利用 Haiku 的速度优势,实现子任务并行处理,提升整体效率。

用 Apifox 测试复杂场景

- Mock 工具响应:通过 Apifox 的 Mock 服务模拟工具调用结果,无需依赖真实外部函数,支持离线验证多智能体逻辑

- 思考预算优化:为复杂任务配置最高 128K Token 的思考预算,在 AIME(10 次运行平均)、多语言 MMMLU 等测试中,这一配置能显著提升性能

接下来,结合实际场景看看 Claude Haiku 4.5 API 的应用价值。

Claude Haiku 4.5 API 的实际应用场景

企业已将 Claude Haiku 4.5 应用于多个领域,以下是典型场景及实现思路:

1. 客服机器人

为消息平台集成实时响应机器人,降低用户等待时间:

# 客服机器人核心逻辑伪代码

def handle_customer_message(user_input):

response = client.messages.create(

model="claude-haiku-4-5",

max_tokens=800,

temperature=0.5,

messages=[{"role": "user", "content": user_input}]

)

return response.content[0].text # 返回机器人回复 该架构能高效应对高流量咨询。

2. 编码辅助工具

在 GitHub Copilot、Cursor 等编码环境中通过 API 提供建议,开发者在公开预览版中输入密钥即可启用。

3. 浏览器自动化

利用其计算机使用能力,开发浏览器扩展。模型可自动导航页面、提取数据、填写表单,性能优于前代模型。

4. 教育与数据分析

- 教育平台:实时生成知识点解释、交互式测验

- 数据分析:结合 SQL 工具,将自然语言转换为数据库查询语句,提升分析效率

在所有场景中,Apifox 均能通过自动化测试保障应用健壮性,例如创建测试套件,验证高负载下的响应速度与准确性。

应用落地时,需遵循最佳实践以最大化效率。

最佳实践与优化技巧

1. 上下文管理:高效维护消息历史,仅保留关键交互内容,避免 Token 浪费

2. 用量监控:通过 Anthropic 控制台跟踪指标,调整参数平衡成本与质量;高吞吐量场景可批量处理请求

3. 安全防护:定期轮换 API 密钥,遵循最小权限原则;实现日志记录,监控异常行为

4. 缓存复用:对频繁使用的提示词启用缓存,减少重复计算,示例代码:

cache = {} # 简易内存缓存

def cached_prompt(client, prompt):

if prompt in cache:

return cache[prompt]

# 首次请求并缓存结果

response = client.messages.create(

model="claude-haiku-4-5",

messages=[{"role": "user", "content": prompt}]

)

cache[prompt] = response

return response 5. 参数微调:默认参数适用于多数场景,创意任务可提高temperature,精准任务可调整top_p

6. 提示词优化:避免过度依赖工具,通过提示词引导模型分步思考,减少无效调用

用 Apifox 测试时,可为响应设置断言(如检查关键字、状态码),确保输出符合预期。

集成 Apifox 增强 API 测试能力

Apifox 是 API 开发与测试的综合平台,尤其适合 Claude Haiku 4.5 的集成测试,核心功能包括:

- 规范导入与用例生成:导入 Claude API 的 OpenAPI 规范,自动生成测试用例,覆盖正常请求、异常场景等

- 端点管理:创建项目后添加 Claude Haiku 4.5 的 API,配置密钥认证,集中管理请求

- 实时响应调试:测试低延迟应用时,模拟实时请求并查看格式化响应,快速定位 JSON payload 问题

- 多智能体流程模拟:通过请求编排功能,模拟多智能体协作的完整流程,验证任务拆分与结果聚合逻辑

- 成本估算:在测试阶段统计 Token 消耗,结合定价模型估算生产环境成本,避免超支

这一集成不仅能加速开发进度,还能确保应用符合行业最佳实践。

安全与伦理考量

Anthropic 在 Claude Haiku 4.5 的设计中重视安全性,异常行为发生率低,但开发者仍需实施额外防护:

- 为用户输入添加内容过滤,防止恶意提示

- 遵守数据隐私法规,避免在提示词中包含敏感信息

- 透明使用 AI:告知用户交互对象为 AI,遵循伦理规范

这些措施能促进模型的负责任应用。

常见问题排查

- 速率限制触发:采用前文提到的指数退避重试机制,避免频繁请求

- 响应无效:调整

max_tokens参数,或优化提示词清晰度 - 认证失败:验证 API 密钥格式是否正确,检查账户权限

- 调试辅助:利用 Apifox 记录完整请求/响应日志,便于追溯问题根源。

未来发展与更新

Anthropic 会持续迭代 Claude 系列模型,建议关注官方公告以获取 Haiku 4.5 的功能增强(如多模态支持)。API 将保持向后兼容性,便于无缝集成更新。

总结

Claude Haiku 4.5 API 为开发者提供了构建智能高效应用的灵活工具,从基础搭建到高级集成,遵循本指南可充分发挥其潜力。而 Apifox 等工具能进一步放大优势,提供免费的测试与优化资源。

在 Claude Haiku 4.5 API 的实际落地过程中,Apifox 的价值可进一步深化:

- 在多智能体客服系统中,用 Apifox 模拟 1000 并发用户请求,测试 Claude Haiku 4.5 的响应延迟与 Token 消耗,提前优化性能瓶颈

- 若需集成工具调用(如支付查询、物流跟踪),Apifox 可创建“工具响应 Mock 集”,覆盖“成功返回”“超时”“参数错误”等场景,确保模型在各种异常下仍能稳定交互

- “API 文档自动生成”功能可将 Claude Haiku 4.5 的调用参数、示例代码、错误码整理为规范化文档,方便团队协作与后期维护,让 AI 应用开发既高效又可靠

在技术快速迭代的当下,细节处的效率提升终将积累为显著竞争优势,将这些 insights 应用到项目中,亲自见证其带来的改变吧。