随着大语言模型能力的提升,越来越多的开发者开始寻求将 AI 能力直接集成到开发环境中。在众多工具中,命令行工具(CLI)因其轻量、可脚本化以及与现有工作流的无缝结合而备受青睐。Google 推出的 Gemini CLI 和社区开源的 OpenCode 是目前备受关注的两个解决方案。

虽然两者都运行在终端中,都旨在通过 AI 辅助编程,但它们的设计理念、交互模式以及核心优势存在显著差异。理解这些差异,有助于开发者根据自身的开发习惯和项目需求做出合适的选择。Gemini CLI 更倾向于作为 Google Gemini 模型在终端的直接延伸,强调轻量级访问和脚本集成;而 OpenCode 则定位为一个完整的“AI 编程代理”,强调对项目结构的理解和从计划到构建的完整开发流程。

安装与环境准备

工具的易用性往往始于安装过程。Gemini CLI 作为一个基于 Node.js 的工具,主要依赖 npm 包管理器进行分发。对于已经拥有 Node.js 环境(版本 20 或更高)的开发者,最直接的方式是使用 npx 进行临时运行,这种方式无需在本地进行全局安装,非常适合初次尝鲜。

npx @google/gemini-cli

如果希望将其作为常用工具固定在系统中,可以通过 npm 进行全局安装。这将允许你在任何目录下直接调用 gemini 命令。

npm install -g @google/gemini-cli

相比之下,OpenCode 提供了更为独立的安装方式,虽然它也支持 npm 安装,但其推荐通过安装脚本直接获取二进制文件。这种方式减少了对本地 Node.js 环境的强依赖,并且更容易适配不同的操作系统环境。对于 macOS 或 Linux 用户,官方推荐的安装脚本如下:

curl -fsSL https://opencode.ai/install | bash

OpenCode 也支持通过 Homebrew 等包管理器安装,这对于习惯使用包管理器维护系统软件的用户来说是一个加分项。

brew install anomalyco/tap/opencode

从安装环节可以看出,Gemini CLI 是典型的 JavaScript 生态工具,紧密依附于 Node.js 环境;OpenCode 则更像是一个独立的系统级应用程序,提供了更广泛的分发渠道。

认证机制与模型接入

在成功安装工具后,下一步必须解决的是身份认证问题,这直接决定了开发者能够使用的模型能力和成本。

Gemini CLI 的认证机制与其作为 Google 产品的身份高度绑定。它提供了一种极低门槛的认证方式——“Login with Google”。对于个人开发者而言,只需使用 Google 账号登录,即可获得免费的使用额度(包括每分钟 60 次请求和每天 1000 次请求)。这种方式无需手动管理复杂的 API Key,通过 OAuth 流程即可完成。

gemini

对于需要更高权限或通过 Google Cloud 进行企业级管控的用户,Gemini CLI 也支持设置环境变量来指定 API Key 或 Google Cloud 项目 ID。

# 使用特定的 Gemini API Key

export GEMINI_API_KEY="YOUR_API_KEY"

gemini

OpenCode 在模型接入上则采取了完全不同的策略。它不仅支持 Google 的模型,还旨在兼容 Claude、GPT 等多种主流大语言模型。因此,OpenCode 的认证过程更多是关于配置“提供商(Provider)”。

在初次运行时,OpenCode 会引导用户选择模型提供商并输入相应的 API Key。为了降低选择困难,OpenCode 提供了一个名为 "OpenCode Zen" 的选项,这是一组经过官方测试和验证的模型集合。

# 在 OpenCode 交互界面中运行连接命令

/connect

用户需要手动将从各个平台(如 Anthropic 或 OpenAI)获取的 API Key 填入配置中。这种设计虽然在初次配置时稍显繁琐,但赋予了开发者极大的自由度,不再受限于单一的模型供应商。

初始化与项目感知

当工具配置完成后,进入实际项目开发阶段,两者对“项目上下文”的处理方式体现了各自深层次的设计逻辑差异。

Gemini CLI 对项目的感知是按需的、轻量的。它并不强制要求用户对项目进行初始化。用户可以在当前目录下直接提问,Gemini CLI 会根据命令参数决定读取哪些文件。如果需要为项目提供持久化的上下文,用户可以手动创建一个 GEMINI.md 文件,在其中编写项目说明或特定的 prompt 指令。

# 启动 Gemini CLI,默认感知当前目录

gemini

# 或者显式包含多个目录作为上下文

gemini --include-directories ../lib,../docs

OpenCode 则强调“代理(Agent)”的概念,认为 AI 应当像一个新加入团队的开发者一样,先对项目进行全盘了解。因此,OpenCode 引入了显式的初始化步骤。进入项目目录后,用户应当运行初始化命令。

# 进入项目目录

cd /path/to/project

# 启动 OpenCode

opencode

# 在交互界面中执行初始化

/init

执行 /init 后,OpenCode 会分析项目结构,并在根目录下生成一个 AGENTS.md 文件。这个文件不仅是 AI 对项目的理解记录,也是用户可以手动维护的文档,建议将其提交到 Git 版本控制中。通过这种方式,OpenCode 建立了一个持久化的项目认知模型,使得后续的交互能更准确地定位代码逻辑。

交互模式与工作流

在实际编码过程中,Gemini CLI 和 OpenCode 展现了两种截然不同的工作流风格。

Gemini CLI 的核心交互类似于“即问即答”的增强版终端聊天。它非常适合快速查询、代码解释或生成简短的脚本。其强大的地方在于不仅支持交互模式,还支持非交互式的单次执行模式,这使得它可以被集成到 shell 脚本或自动化工作流中。

例如,要在脚本中自动生成代码解释并以 JSON 格式输出,Gemini CLI 提供了非常标准的命令行接口:

gemini -p "Explain the architecture of this codebase" --output-format json

这种设计使得 Gemini CLI 很容易成为现有 DevOps 流程中的一个环节,比如用于自动生成代码审查意见或提取日志信息。

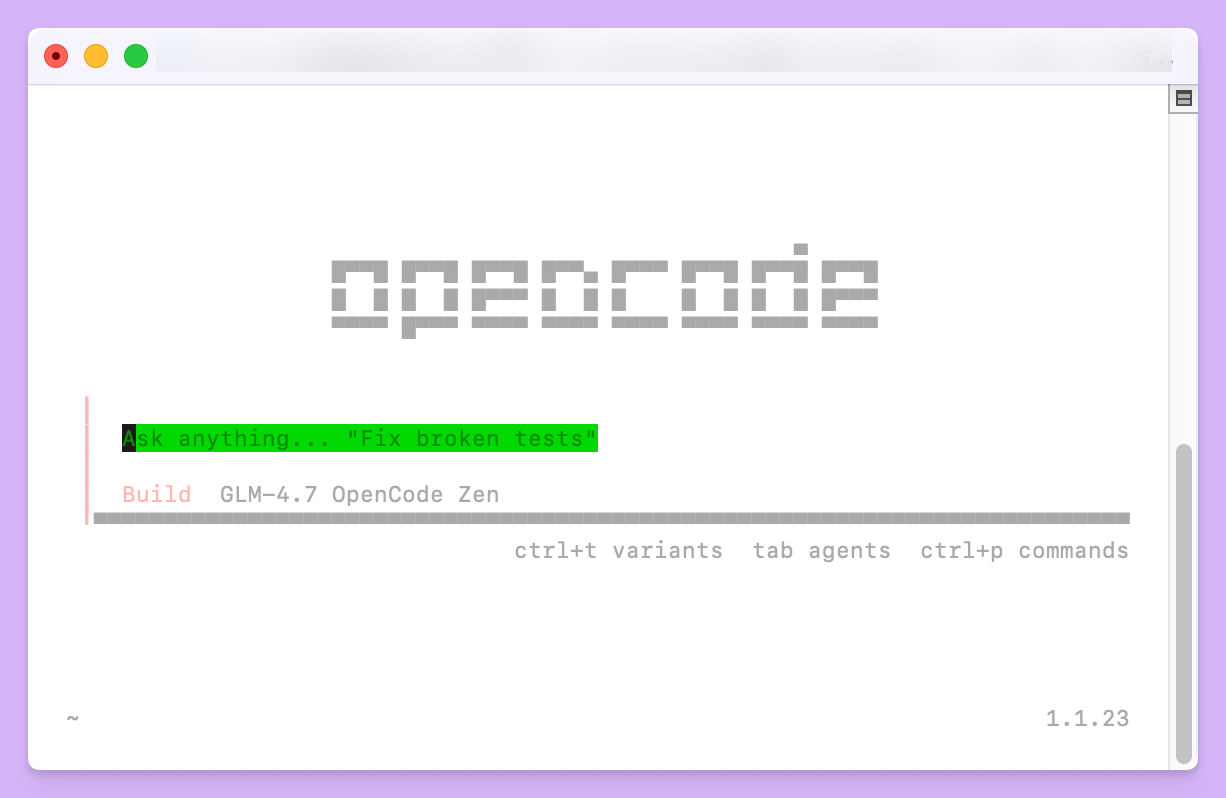

OpenCode 则构建了一套更为完整的软件工程工作流,它将开发过程拆分为“计划(Plan)”和“构建(Build)”两个阶段。在 OpenCode 的界面中,开发者可以通过 Tab 键在两种模式间切换。

在“计划模式”下,AI 不会直接修改代码,而是会根据用户的需求(如“添加一个删除笔记的功能”)制定详细的实施计划。开发者可以像指导初级工程师一样,对计划进行反馈、补充细节或提供参考图片。

<TAB> # 切换到 Plan 模式

When a user deletes a note, flag it as deleted in the database.

Then create a screen showing recently deleted notes.

确认计划无误后,开发者再次按 Tab 键切换回“构建模式”,此时 AI 才会开始执行具体的代码修改。这种双阶段设计大大降低了 AI 生成错误代码的风险,让开发者在代码变更前有充分的思考和管控空间。

此外,OpenCode 极其重视操作的可逆性。如果在构建过程中 AI 修改了代码但结果不符合预期,用户可以使用 undo 命令直接回滚更改。

/undo

这种原生支持撤销和重做的能力,配合其 TUI(终端用户界面)体验,使得 OpenCode 更像是一个驻留在终端里的交互式 IDE,而不仅仅是一个问答机器人。

上下文管理与文件操作

在处理大型项目时,如何精准地将相关文件传递给 AI 是一个关键问题。

Gemini CLI 允许用户通过自然语言或参数指定文件,同时支持 Google Search grounding(接地),这意味着它可以联网搜索实时信息来辅助回答。它还支持通过 MCP(Model Context Protocol)协议扩展上下文来源,这使得开发者可以自行编写服务来连接数据库或内部工具。

OpenCode 在文件检索上提供了一套类似 IDE 的模糊搜索机制。在对话框中,用户可以使用 @ 符号快速引用项目中的特定文件,这极大地提高了指代特定模块的效率。

How is authentication handled in @packages/functions/src/api/index.ts

配合 AGENTS.md 提供的全局认知,OpenCode 能够更好地理解文件之间的依赖关系。同时,OpenCode 对 LSP(语言服务器协议)的支持意味着它能够利用项目中的类型定义和符号跳转信息,从而生成更符合语法规范的代码。

功能对比总结

为了更清晰地展示两者的定位差异,我们可以通过下表进行核心特性的对比:

| 特性维度 | Gemini CLI | OpenCode |

|---|---|---|

| 核心定位 | Google 生态下的通用终端 AI 助手 | 专注于软件开发全流程的 AI 编程代理 |

| 模型支持 | Google Gemini 系列(深度集成) | 供应商中立(支持 Claude, GPT, Gemini 等) |

| 认证方式 | Google 账号登录(便捷)或 API Key | 配置各供应商 API Key |

| 工作流 | 请求-响应式,支持脚本化管道操作 | 计划-构建双模式,强调人机协作迭代 |

| 项目理解 | 按需加载,可选 GEMINI.md |

强制初始化,生成 AGENTS.md 维护认知 |

| 特色功能 | Google 搜索接地,Github Action 集成 | 撤销/重做 (/undo),模糊文件搜索 (@) |

| 扩展性 | 支持 MCP 协议连接外部工具 | 支持 LSP 协议提升代码感知 |

适用场景分析

基于上述分析,我们可以看出这两款工具分别适合不同的使用场景。

Gemini CLI 非常适合那些深度依赖 Google 生态,或者需要一个轻量级工具来辅助日常任务的开发者。如果你经常需要编写 Shell 脚本,希望在脚本中引入 AI 能力来处理文本或分析日志,Gemini CLI 的非交互模式和管道支持将是无可替代的优势。它的安装和登录过程极其简单,对于只想快速获得 AI 帮助而不想进行繁琐配置的用户来说,是极佳的入门选择。

OpenCode 则更适合将终端作为主要开发环境的硬核程序员。如果你正在进行复杂的特性开发,需要 AI 理解整个项目的架构,并且希望对 AI 的修改计划进行精细控制,OpenCode 的“计划-构建”模式会提供更好的体验。它对多模型的支持也让那些对特定模型(如 Claude 3.5 Sonnet)有偏好的开发者能够得偿所愿。OpenCode 更像是一个可以结对编程的虚拟同事,而不仅仅是一个查询工具。

两者并非互斥关系,在实际工作中,开发者完全可以根据当前任务的性质交替使用。对于快速的单点问题查询使用 Gemini CLI,而对于复杂的模块开发则切换到 OpenCode,从而最大化地利用终端 AI 带来的生产力提升。

开发必备:API 全流程管理神器 Apifox

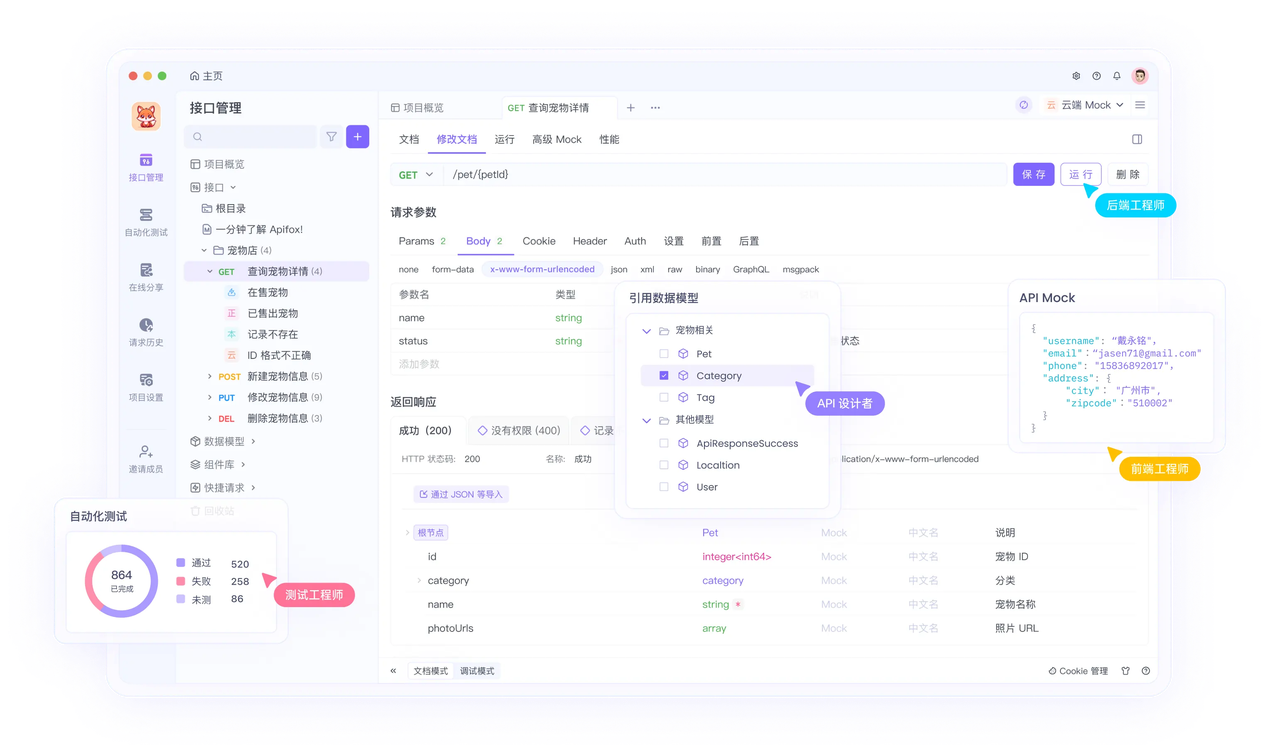

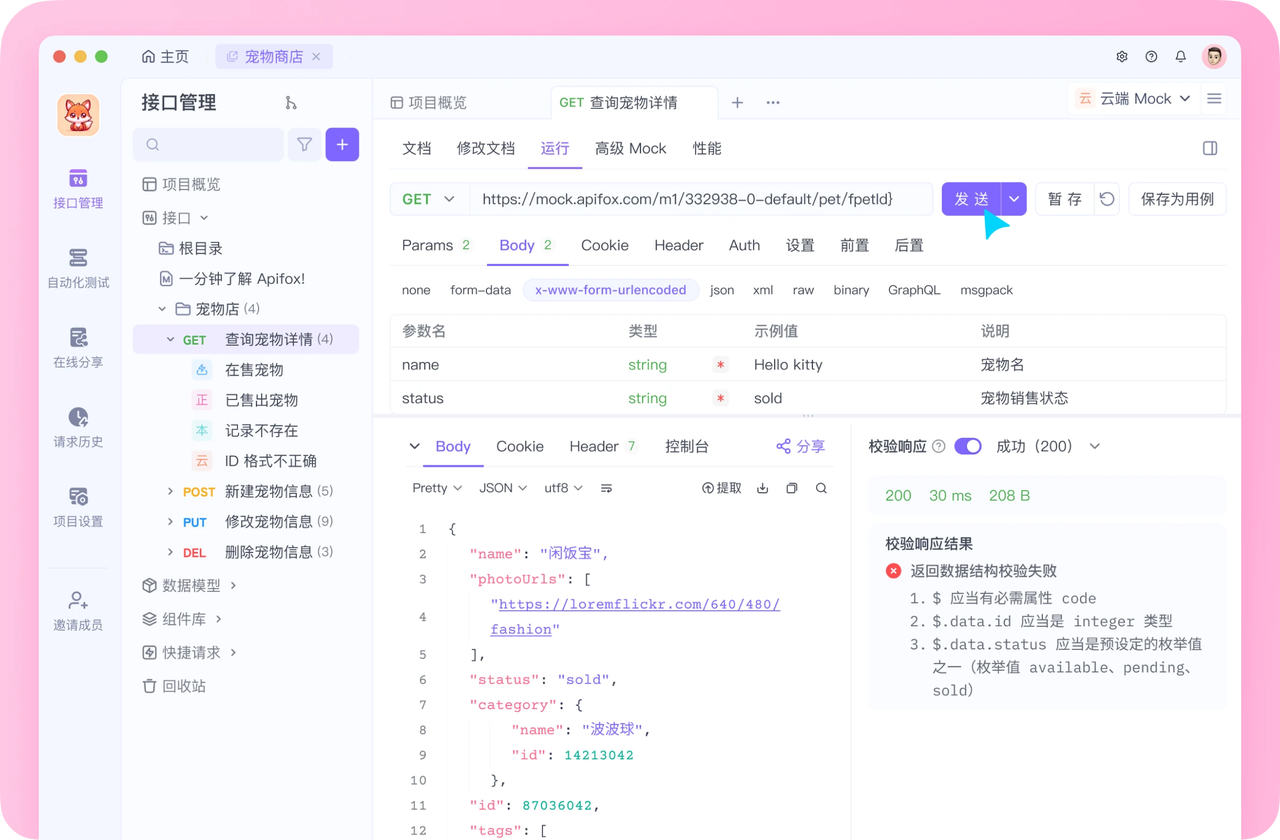

介绍完上文的内容,我想额外介绍一个对开发者同样重要的效率工具 —— Apifox。作为一个集 API 文档、API 调试、API 设计、API 测试、API Mock、自动化测试等功能于一体的 API 管理工具,Apifox 可以说是开发者提升效率的必备工具之一。

如果你正在开发项目需要进行接口调试,不妨试试 Apifox。注册过程非常简单,你可以直接在这里注册使用。

注册成功后可以先看看官方提供的示例项目,这些案例都是经过精心设计的,能帮助你快速了解 Apifox 的主要功能。

使用 Apifox 的一大优势是它完全兼容 Postman 和 Swagger 数据格式,如果你之前使用过这些工具,数据导入会非常方便。而且它的界面设计非常友好,即使是第一次接触的新手也能很快上手,快去试试吧!